Introducciones a los algoritmos de ciencia de datos

Una descripción de alto nivel de los algoritmos esenciales utilizados en Data Science. Como ya sabe, la ciencia de datos es un campo de estudio en el que las decisiones se toman en función de los conocimientos que obtenemos de los datos en lugar de los enfoques deterministas clásicos basados en reglas. Por lo general, podemos dividir una tarea de aprendizaje automático en tres partes

- Obteniendo los datos y mapeando el problema del negocio,

- Aplicando técnicas de aprendizaje automático y observando la métrica de rendimiento

- Probar e implementar el modelo

En todo este ciclo de vida, utilizamos varios algoritmos de ciencia de datos para resolver la tarea en cuestión. En este artículo, dividiremos los algoritmos más utilizados en función de sus tipos de aprendizaje y tendremos una discusión de alto nivel sobre ellos.

Tipos de algoritmos de ciencia de datos

Con base en las metodologías de aprendizaje, podemos simplemente dividir el aprendizaje automático o los algoritmos de ciencia de datos en los siguientes tipos

- Algoritmos Supervisados

- Algoritmos no supervisados

1. Algoritmos supervisados

Como su nombre indica, los algoritmos supervisados son una clase de algoritmos de aprendizaje automático en los que el modelo se entrena con los datos etiquetados. Por ejemplo, en función de los datos históricos, desea predecir que un cliente incumplirá un préstamo o no. Después del proceso previo y la ingeniería de características de los datos etiquetados, los algoritmos supervisados se entrenan sobre los datos estructurados y se prueban en un nuevo punto de datos o, en este caso, para predecir un incumplimiento de préstamo. Vamos a sumergirnos en los algoritmos de aprendizaje automático supervisados más populares.

- K vecinos más cercanos

K vecinos más cercanos (KNN) es uno de los algoritmos de aprendizaje automático más simples pero potentes. Es un algoritmo supervisado donde la clasificación se realiza en función de k puntos de datos más cercanos. La idea detrás de KNN es que los puntos similares se agrupan, midiendo las propiedades de los puntos de datos más cercanos podemos clasificar un punto de datos de prueba. Por ejemplo, estamos resolviendo un problema de clasificación estándar donde queremos predecir que un punto de datos pertenece a la clase A o clase B. Deje k = 3, ahora probaremos 3 puntos de datos más cercanos del punto de datos de prueba, si dos de ellos pertenecen a la clase A declararemos el punto de datos de prueba como clase A, de lo contrario, clase B. El valor correcto de K se encuentra a través de la validación cruzada. Tiene una complejidad de tiempo lineal, por lo tanto, no se puede utilizar para aplicaciones de baja latencia.

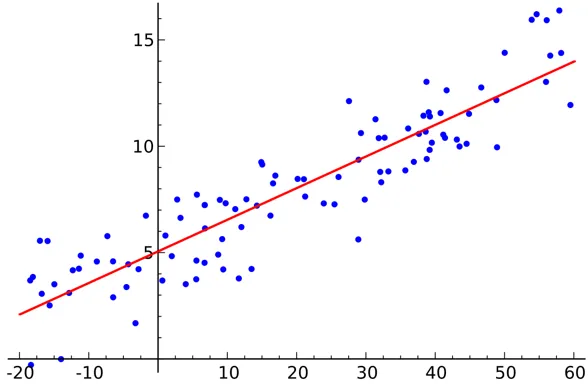

- Regresión lineal

La regresión lineal es un algoritmo de ciencia de datos supervisado.

Salida:

La variable es continua. La idea es encontrar un hiperplano donde el número máximo de puntos se encuentre en el hiperplano. Por ejemplo, predecir la cantidad de lluvia es un problema de regresión estándar en el que se puede usar la regresión lineal. La regresión lineal supone que la relación entre las variables independientes y dependientes es lineal y hay muy poca o ninguna multicolinealidad.

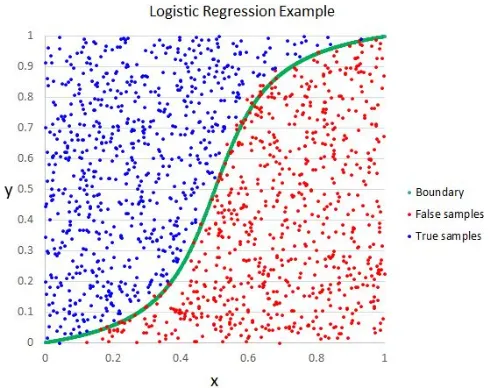

- Regresión logística

Aunque el nombre dice regresión, la regresión logística es un algoritmo de clasificación supervisado.

Salida:

La intuición geométrica es que podemos separar diferentes etiquetas de Clase usando un límite de decisión lineal. La variable de salida de la regresión logística es categórica. Tenga en cuenta que no podemos utilizar el error cuadrático medio como una función de costo para la regresión logística, ya que no es convexo para la regresión logística.

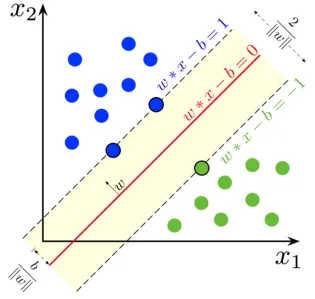

- Máquinas de vectores soporte

En la regresión logística, nuestro lema principal era encontrar una superficie lineal de separación.

Salida:

Podemos considerar la máquina de vectores de soporte como una extensión de esta idea donde necesitamos encontrar un hiperplano que maximice el margen. Pero, ¿qué es un margen? Para un vector W (la superficie de decisión con la que tenemos que llegar), dibujamos dos líneas paralelas en ambos lados. La distancia entre estas dos líneas se llama margen. SVM asume que los datos son linealmente separables. Aunque podemos usar SVM para datos no lineales también con el truco Kernel.

- Árbol de decisión

El Árbol de decisión es un clasificador anidado basado en If-Else que utiliza una estructura gráfica similar a un árbol para tomar la decisión. Los árboles de decisión son muy populares y uno de los algoritmos de aprendizaje automático supervisados más utilizados en toda el área de la ciencia de datos. Proporciona una mejor estabilidad y precisión en la mayoría de los casos comparativamente que otros algoritmos supervisados y robusto a los valores atípicos. La variable de salida del árbol de decisión suele ser categórica, pero también se puede utilizar para resolver problemas de regresión.

- Conjuntos

Los conjuntos son una categoría popular de algoritmos de ciencia de datos en los que se utilizan varios modelos juntos para obtener un mejor rendimiento. Si está familiarizado con Kaggle (una plataforma de Google para practicar y competir en los desafíos de la ciencia de datos), encontrará que la mayoría de las soluciones ganadoras están utilizando algún tipo de conjuntos.

Podemos dividir aproximadamente los conjuntos en las siguientes categorías

- Harpillera

- Impulsar

- Apilado

- Cascada

Random Forest, Gradient Boosting Decision Trees son ejemplos de algunos algoritmos de conjunto populares.

2. Algoritmos no supervisados

Se utilizan algoritmos no supervisados para las tareas en las que los datos no están etiquetados. El caso de uso más popular de los algoritmos no supervisados es la agrupación. La agrupación es la tarea de agrupar puntos de datos similares sin intervención manual. Analicemos algunos de los algoritmos populares de aprendizaje automático sin supervisión

- K significa

K Means es un algoritmo aleatorio no supervisado utilizado para la agrupación. K Means sigue los pasos a continuación

1.Inicialice K puntos al azar (c1, c2..ck)

2. Para cada punto (Xi) en el conjunto de datos

Seleccione el Ci más cercano (i = 1, 2, 3..k)

Agregar Xi a Ci

3. Vuelva a calcular el centroide utilizando las métricas adecuadas (es decir, la distancia intragrupo)

4, repita el paso (2) (3) hasta que converja

- K significa ++

El paso de inicialización en K significa es puramente aleatorio y, según la inicialización, la agrupación cambia drásticamente. K significa que ++ resuelve este problema inicializando k de forma probabilística en lugar de aleatorización pura. K significa ++ es más estable que el clásico K significa.

- K medoides:

K medoids es también un algoritmo de agrupamiento basado en K medias. La principal diferencia entre los dos es que los centroides de K significa que no existe necesariamente en el conjunto de datos, que no es el caso de K medoides. Los medoides K ofrecen una mejor interpretabilidad de los grupos. K significa que minimiza el error cuadrado total, mientras que los medoides K minimizan la diferencia entre puntos.

Conclusión

En este artículo, discutimos los algoritmos de aprendizaje automático más populares utilizados en el campo de la ciencia de datos. Después de todo esto, una pregunta puede venir a su mente que ' ¿Qué algoritmo es el mejor? ' Claramente no hay ganador aquí. Depende únicamente de la tarea en cuestión y los requisitos comerciales. Como práctica recomendada, siempre comienza con el algoritmo más simple y aumenta la complejidad gradualmente.

Artículos recomendados

Esta ha sido una guía de algoritmos de ciencia de datos. Aquí hemos discutido una visión general de los algoritmos de ciencia de datos y dos tipos de algoritmos de ciencia de datos. También puede consultar nuestros artículos para obtener más información.

- Plataforma de ciencia de datos

- Lenguajes de ciencia de datos

- Algoritmos de clasificación

- Algoritmos de minería de datos

- Técnicas más utilizadas de aprendizaje conjunto

- Formas simples de crear árbol de decisión

- Guía completa del ciclo de vida de la ciencia de datos