¿Qué es el ecosistema Apache Hadoop?

Apache Hadoop Ecosystem es un marco o una plataforma de datos de código abierto asignada para guardar y examinar las enormes colecciones de datos no estructurados. En todo el mundo, se está impulsando una tonelada de datos desde numerosas plataformas digitales con la tecnología innovadora líder de big data. Además, Apache Hadoop fue el primero en obtener este flujo de innovación.

¿Qué comprende la arquitectura / ecosistema de datos Hadoop?

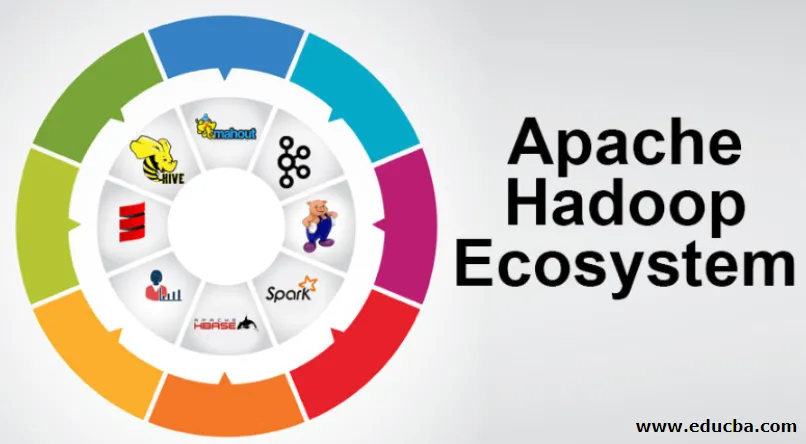

El Hadoop Ecosystem no es un lenguaje de programación o un servicio, es un marco o plataforma que se ocupa de los problemas de big data. Puede identificarlo como una suite que envuelve varios servicios, como almacenar, ingerir, mantener y analizar dentro de él. Luego examine y obtenga una idea concisa sobre cómo funcionan los servicios exclusivamente y en cooperación. La arquitectura de Apache Hadoop se compone de diferentes innovaciones y elementos de Hadoop a través de los cuales incluso los problemas de información complicados se pueden resolver de manera efectiva.

A continuación se muestra la representación de cada parte: -

1) Namenode: guía el proceso de información

2) Datanode: compone la información para el almacenamiento local. Guardar toda la información en un lugar singular no se sugiere continuamente, ya que podría causar la pérdida de información en caso de interrupción.

3) Rastreador de tareas: reciben tareas asignadas al nodo esclavo

4) Mapa: toma información de una secuencia y cada línea se maneja dividida para dividirla en diferentes campos

5) Disminuir: aquí los campos, adquiridos a través del Mapa, se recopilan o vinculan entre sí

Ecosistema Apache Hadoop - paso a paso

Cada elemento del ecosistema de Hadoop, como aspectos específicos son obvios. La perspectiva integral de la estructura de Hadoop ofrece una calidad notable a los sistemas de archivos distribuidos de Hadoop (HDFS), Hadoop YARN, Hadoop MapReduce y Hadoop MapReduce del ecosistema de Hadoop. Hadoop incluso ofrece a todas las bibliotecas de Java, importantes registros de Java, reflexión a nivel del sistema operativo, ventajas y secuencias de comandos para operar Hadoop, Hadoop YARN es un método para delinear negocios y administrar recursos en grupo. En la configuración de Hadoop, el HDFS proporciona un paso de alto rendimiento a la información de la aplicación y Hadoop MapReduce ofrece una preparación paralela basada en YARN de una amplia variedad de datos.

Descripción del ecosistema Apache Hadoop

Es un tema fundamental para comprender antes de comenzar a trabajar con el ecosistema Hadoop. A continuación se encuentran los componentes esenciales:

- HDFS: esta es la parte central del ecosistema Hadoop y puede guardar una enorme cantidad de información no estructurada, estructurada y semiestructurada.

- HILO: Se asemeja a la mente del ecosistema Hadoop y todo el manejo se realiza directamente aquí, lo que puede incorporar la asignación de activos, la programación de trabajos y la preparación de acciones.

- MapReduce: es una combinación de dos procesos, descritos como Map y Reduce y se compone esencialmente de partes que preparan grandes colecciones de información utilizando algoritmos paralelos y dispersos dentro del ecosistema Hadoop.

- Apache Pig: es un lenguaje del procedimiento, que se utiliza para aplicaciones de manejo paralelo para procesar vastas colecciones de información en condiciones Hadoop y este lenguaje es una opción para la programación Java.

- HBase: es una base de datos de código abierto y no asociada o NoSQL. Refuerza todos los tipos de información, por lo que puede manejar cualquier tipo de información dentro de un marco Hadoop.

- Mahout, Spark MLib: Mahout se utiliza para el aprendizaje automático y da naturaleza a la creación de aplicaciones de aprendizaje automático.

- Zookeeper: para tratar con los grupos, se puede utilizar Zookeeper, de lo contrario se le llama el señor de la coordinación, que puede proporcionar administraciones operativas confiables, rápidas y resueltas para los grupos de Hadoop.

- Oozie: Apache Oozie opera la programación del trabajo y funciona como un servicio de alerta y reloj dentro del ecosistema Hadoop.

- Ambari: es una empresa de Apache Software Foundation y puede realizar el ecosistema de Hadoop progresivamente flexible.

Hadoop HILO:

Piense en YARN como la mente de su ecosistema Hadoop. Representa la totalidad de sus operaciones de procesamiento asignando activos y tareas de planificación.

Tiene dos segmentos notables que son ResourceManager y NodeManager.

- ResourceManager: - De nuevo es un nodo importante en la división operativa. Obtiene las consultas de preparación y luego pasa las preguntas a los NodeManagers relacionados, respectivamente, donde ocurre el manejo genuino.

- NodeManagers: - Se instalan en cada DataNode. Está a cargo de la ejecución de una asignación en cada DataNode.

¿Cómo funciona apache Hadoop?

- Está destinado a ascender de servidores individuales a una gran cantidad de máquinas, cada una de las cuales proporciona capacidad y cómputo local. En lugar de depender del equipo para transmitir una alta accesibilidad, la biblioteca en sí misma tiene la intención de distinguir y lidiar con las decepciones en la capa de aplicación, por lo que transmite un servicio extremadamente accesible a través de un montón de PC, cada una de las cuales podría estar inclinada a decepciones.

- Mire más allá, sin embargo, y hay un encanto significativamente creciente en el trabajo. Hadoop es totalmente modular, lo que implica que puede cambiar prácticamente cualquiera de sus segmentos por una herramienta de software alternativa. Eso hace que la arquitectura sea increíblemente adaptable, igual de poderosa y efectiva.

Apache Hadoop Spark:

- Apache Spark es un sistema para el análisis de información en tiempo real en un entorno informático disperso. Implementa cálculos en memoria para aumentar la velocidad del manejo de la información.

- Es más rápido para manejar información a gran escala ya que utiliza cálculos en memoria y diferentes mejoras. En este sentido, requiere una gran fuerza de procesamiento.

¿Cómo funciona Apache Pig?

- Apache Pig es un sistema beneficioso que Yahoo fue desarrollado para examinar vastas posiciones de información de manera efectiva y sin problemas. Proporciona un lenguaje de flujo de información de nivel superior Pig Latin que es mejorado, extensible y fácil de usar.

- El componente excepcional de los programas de Pig en el que su composición está disponible para una paralelización sustancial hace que esto sea sencillo para cuidar de importantes colecciones de información.

Caso de uso de cerdo:

- La información médica privada de un individuo es privada y no debe divulgarse a otras personas. Estos datos deben ocultarse para mantener el secreto, sin embargo, la información de los servicios médicos es enorme hasta el punto de que es esencial reconocer y excluir la información de salud individual. Apache Pig se puede utilizar en tales condiciones para no reconocer los datos de salud.

Conclusión:

- Está diseñado para ascender de un solo servidor a una gran cantidad de máquinas, todo lo cual proporciona capacidad y cálculo cercano. Mire más allá, sin embargo, y cada vez hay más encanto en el trabajo.

- Hadoop es totalmente modular, lo que implica que puede cambiar prácticamente cualquiera de sus partes por una herramienta de software alternativa. Eso hace que la estructura sea fantásticamente adaptable, igual de poderosa y efectiva.

Artículos recomendados

Esta ha sido una guía para el ecosistema Apache Hadoop. Aquí hemos discutido qué es el ecosistema Apache Hadoop? Descripción general de la arquitectura de Hadoop y el funcionamiento del ecosistema de Hadoop. También puede consultar nuestros otros artículos sugeridos para obtener más información:

- Componentes del ecosistema de Hadoop

- Cómo instalar Apache

- Apache Spark Training

- Carrera profesional en Hadoop