Introducción a Hadoop Framework

Antes de profundizar en el marco técnico de Hadoop, comenzaremos con un ejemplo simple.

Hay una granja que cosecha tomates y los almacena en una sola área de almacenamiento, ahora con la creciente demanda de verduras, la granja comenzó a cosechar papas, zanahorias, con la creciente demanda había escasez de agricultores, por lo que contrataron a más agricultores. Después de un tiempo se dieron cuenta de que había una escasez en el área de almacenamiento, por lo que distribuyeron las verduras en diferentes áreas de almacenamiento. Cuando se trata de recuperar los datos, todos ellos trabajan en paralelo con su propio espacio de almacenamiento.

Entonces, ¿cómo se relaciona esta historia con los grandes datos?

Anteriormente teníamos datos limitados, con el procesador limitado y una unidad de almacenamiento. Pero luego, la generación de datos aumentó, lo que condujo a un gran volumen y a diferentes variedades: estructuradas, semiestructuradas y no estructuradas, por lo que la solución fue utilizar el almacenamiento distribuido para cada procesador, esto permitió un fácil acceso para almacenar y acceder a los datos.

Entonces, ahora podemos reemplazar los vegetales como diferentes tipos de datos y lugar de almacenamiento como los lugares distribuidos para almacenar los datos y los diferentes trabajadores que son cada procesador.

Así que el desafío es Big Data y Hadoop juega el papel de la Solución.

HADOOP

1. Solución para BIG DATA: ya que trata con complejidades de alto volumen, velocidad y variedad de datos.

2. Conjunto del proyecto de código abierto.

3. Almacena un gran volumen de datos de manera confiable y permite enormes cálculos distribuidos.

4. Los atributos clave de Hadoop son redundancia y confiabilidad (absolutamente sin pérdida de datos).

5. Se centra principalmente en el procesamiento por lotes.

6. Se ejecuta en hardware básico: no necesita comprar ningún hardware costoso especial.

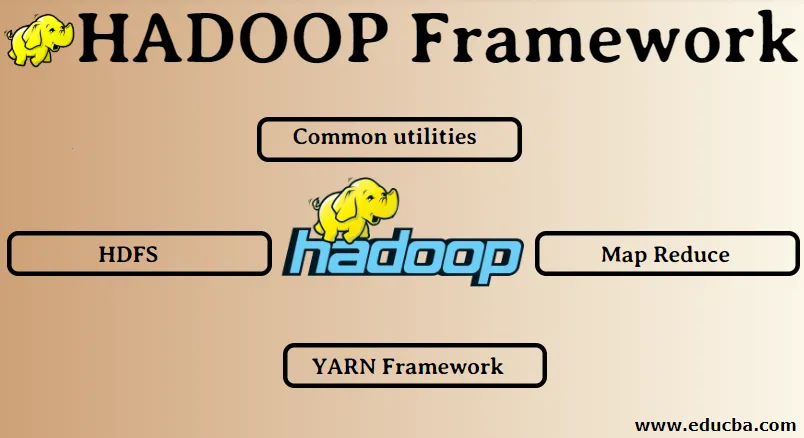

Marco Hadoop:

1. Utilidades comunes

2. HDFS

3. Mapa Reducir

4. Marco de HILO

1. Utilidades comunes:

También se llama el Hadoop común. Estas no son más que las bibliotecas, archivos, scripts y utilidades JAVA que los otros componentes de Hadoop realmente requieren para realizar.

2. HDFS: Sistema de archivos distribuidos de Hadoop

¿Por qué Hadoop ha elegido incorporar un sistema de archivos distribuido?

Comprendamos esto con un ejemplo: necesitamos leer 1 TB de datos y tenemos una máquina con 4 canales de E / S, cada canal tiene 100 MB / s, tardó 45 minutos en leer todos los datos. Ahora, 10 máquinas leen la misma cantidad de datos, cada una con 4 canales de E / S, cada canal tiene 100 MB / s. ¿Adivina la cantidad de tiempo que tomó leer los datos? 4.3 minutos HDFS resuelve el problema de almacenar big data. Los dos componentes principales de HDFS son NAME NODE y DATA NODE. El nodo de nombre es el maestro, también podemos tener un nodo de nombre secundario en caso de que el nodo de nombre primario deje de funcionar, el nodo de nombre secundario actuará como una copia de seguridad. El nodo de nombre básicamente mantiene y administra los nodos de datos almacenando metadatos. El nodo de datos es el esclavo, que es básicamente el hardware básico de bajo costo. Podemos tener múltiples nodos de datos. El nodo de datos almacena los datos reales. Este nodo de datos admite el factor de replicación, suponga que si un nodo de datos se cae, el otro nodo de datos replicado puede acceder a los datos, por lo tanto, se mejora la accesibilidad de los datos y se evita la pérdida de datos.

3. Mapa Reducir:

Resuelve el problema del procesamiento de big data. Comprendamos que el concepto de mapa se reduce al resolver este problema del mundo real. La compañía ABC quiere calcular sus ventas totales, según la ciudad. Ahora aquí el concepto de tabla hash no funcionará porque los datos están en terabytes, por lo que utilizaremos el concepto Map-Reduce.

Hay dos fases: a) MAPA. b) REDUCIR

a) Mapa : Primero, dividiremos los datos en fragmentos más pequeños llamados mapeadores sobre la base del par clave / valor. Entonces, aquí la clave será el nombre de la ciudad y el valor será el total de ventas. Cada mapeador obtendrá los datos de cada mes que dan un nombre de ciudad y las ventas correspondientes.

b) Reducir: obtendrá estos montones de datos y cada reductor será responsable de las ciudades Norte / Oeste / Este / Sur. Por lo tanto, el trabajo del reductor será recolectar estos pequeños trozos y convertirlos en grandes cantidades (al sumarlos) para una ciudad en particular.

Marco 4.YARN: Otro negociador de recursos.

La versión inicial de Hadoop tenía solo dos componentes: Map Reduce y HDFS. Más tarde se dio cuenta de que Map Reduce no podía resolver muchos problemas de big data. La idea era quitar las responsabilidades de gestión de recursos y programación de trabajos del antiguo motor de reducción de mapas y asignarlo a un nuevo componente. Así es como YARN entró en escena. Es la capa intermedia entre HDFS y Map Reduce la responsable de administrar los recursos del clúster.

Tiene dos roles clave que desempeñar: a) Programación de trabajos. b) gestión de recursos

a) Programación de trabajos: cuando se entrega una gran cantidad de datos para el procesamiento, es necesario distribuirlos y dividirlos en diferentes tareas / trabajos. Ahora el JS decide a qué trabajo se le debe dar la máxima prioridad, el intervalo de tiempo entre dos trabajos, la dependencia entre los trabajos, verifica que no haya superposición entre los trabajos en ejecución.

b) Gestión de recursos: para procesar los datos y almacenarlos necesitamos recursos, ¿verdad? Por lo tanto, el administrador de recursos proporciona, administra y mantiene los recursos para almacenar y procesar los datos.

¡Así que ahora tenemos claro el concepto de Hadoop y cómo resuelve los desafíos creados por BIG DATA!

Artículos recomendados

Esta ha sido una guía de Hadoop Framework. Aquí también hemos discutido los 4 principales marcos de Hadoop. También puede consultar nuestros otros artículos sugeridos para obtener más información:

- Base de datos de Hadoop

- Ecosistema Hadoop

- Usos de Hadoop

- Empleos de Administrador de Hadoop

- Administrador de Hadoop | Habilidades y trayectoria profesional