Introducción a la eliminación hacia atrás

A medida que el hombre y la máquina golpean hacia la evolución digital, las máquinas de diversas técnicas están contando para no solo entrenarse sino también entrenarse inteligentemente para salir con un mejor reconocimiento de los objetos del mundo real. Tal técnica introducida anteriormente llamada "Eliminación hacia atrás" que pretendía favorecer las características indispensables al tiempo que erradicaba las características nugativas para permitir una mejor optimización en una máquina. La competencia total del reconocimiento de objetos por parte de Machine es proporcional a las características que está considerando.

Las características que no tienen referencia en la salida prevista deben descargarse de la máquina y se concluye mediante la eliminación hacia atrás. La precisión y la complejidad temporal del reconocimiento de cualquier objeto de palabra real por parte de Machine dependen de su aprendizaje. Por lo tanto, la eliminación hacia atrás juega su papel rígido para la selección de funciones. Considera que la tasa de dependencia de las características de la variable dependiente encuentra el significado de su pertenencia en el modelo. Para acreditar esto, verifica la tasa calculada con un nivel de significancia estándar (digamos 0.06) y toma una decisión para la selección de características.

¿Por qué implicamos la eliminación hacia atrás ?

Los rasgos innecesarios y redundantes impulsan la complejidad de la lógica de la máquina. Devora el tiempo y los recursos del modelo innecesariamente. Por lo tanto, la técnica mencionada anteriormente juega un papel competente para forjar el modelo a simple. El algoritmo cultiva la mejor versión del modelo al optimizar su rendimiento y truncar sus recursos designados prescindibles.

Reduce las características menos notables del modelo que causa ruido al decidir la línea de regresión. Los rasgos de objeto irrelevantes pueden generar una clasificación y predicción erróneas. Las características irrelevantes de una entidad pueden constituir un desequilibrio en el modelo con respecto a otras características significativas de otros objetos. La eliminación hacia atrás fomenta la adaptación del modelo al mejor de los casos. Por lo tanto, se recomienda la eliminación hacia atrás para usar en un modelo.

¿Cómo aplicar la eliminación hacia atrás?

La eliminación hacia atrás comienza con todas las variables de características, probándola con la variable dependiente bajo un ajuste seleccionado del criterio del modelo. Comienza a erradicar aquellas variables que deterioran la línea de regresión adecuada. Repetir esta eliminación hasta que el modelo alcance un buen ajuste. A continuación se detallan los pasos para practicar la eliminación hacia atrás:

Paso 1: elija el nivel de significación apropiado para residir en el modelo de la máquina. (Tome S = 0.06)

Paso 2: Alimente todas las variables independientes disponibles al modelo con respecto a la variable dependiente y calcule la pendiente e intercepte para dibujar una línea de regresión o línea de ajuste.

Paso 3: atraviese con todas las variables independientes que poseen el valor más alto (Tome I) una por una y proceda con el siguiente brindis:

a) Si I> S, ejecute el 4to paso.

b) De lo contrario, aborta y el modelo es perfecto.

Paso 4: elimine la variable elegida e incremente el recorrido.

Paso 5: Vuelva a forjar el modelo nuevamente y calcule la pendiente e intercepción de la línea de ajuste nuevamente con variables residuales.

Los pasos antes mencionados se resumen en el rechazo de aquellas características cuya tasa de significancia está por encima del valor de significancia seleccionado (0.06) para evadir la sobreclasificación y la sobreutilización de recursos que se observaron como de alta complejidad.

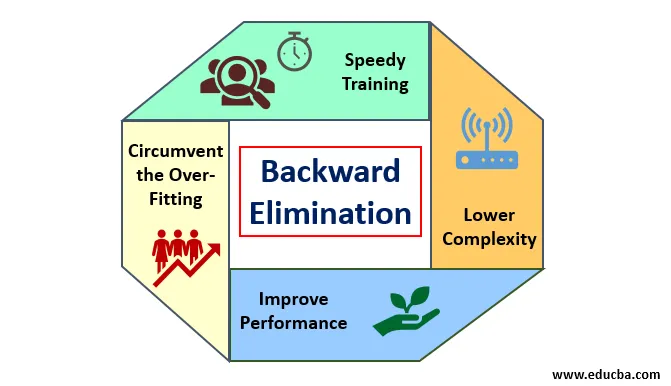

Méritos y deméritos de la eliminación hacia atrás

Aquí hay algunos méritos y deméritos de eliminación hacia atrás que se detallan a continuación:

1. Méritos

Los méritos de la eliminación hacia atrás son los siguientes:

- Entrenamiento rápido: la máquina está entrenada con un conjunto de características de patrón disponibles que se realiza en muy poco tiempo si se eliminan características no esenciales del modelo. El entrenamiento rápido del conjunto de datos aparece solo cuando el modelo trata con características significativas y excluye todas las variables de ruido. Dibuja una simple complejidad para el entrenamiento. Pero el modelo no debe sufrir un ajuste insuficiente debido a la falta de características o muestras inadecuadas. La característica de la muestra debe ser abundante en un modelo para la mejor clasificación. El tiempo requerido para entrenar el modelo debe ser menor mientras se mantiene la precisión de la clasificación y se deja sin una variable de predicción insuficiente.

- Complejidad más baja: la complejidad del modelo es alta si el modelo contempla el alcance de las características, incluido el ruido y las características no relacionadas. El modelo consume mucho espacio y tiempo para procesar una variedad de características. Esto puede aumentar la tasa de precisión del reconocimiento de patrones, pero la tasa también puede contener ruido. Para deshacerse de una complejidad tan alta del modelo, el algoritmo de eliminación hacia atrás juega un papel necesario al reducir las características no deseadas del modelo. Simplifica la lógica de procesamiento del modelo. Solo unas pocas características esenciales son amplias para lograr un buen ajuste que contenga una precisión razonable.

- Mejorar el rendimiento: el rendimiento del modelo depende de muchos aspectos. El modelo se optimiza mediante la eliminación hacia atrás. La optimización del modelo es la optimización del conjunto de datos utilizado para entrenar el modelo. El rendimiento del modelo es directamente proporcional a su tasa de optimización que se basa en la frecuencia de datos significativos. El proceso de eliminación hacia atrás no está destinado a iniciar la alteración de ningún predicador de baja frecuencia. Pero solo comienza la alteración de los datos de alta frecuencia porque la complejidad del modelo depende principalmente de esa parte.

- Evite el sobreajuste: la situación de sobreajuste ocurre cuando el modelo tiene demasiados conjuntos de datos y se realiza una clasificación o predicción en la que algunos predicadores obtienen el ruido de otras clases. En este ajuste, el modelo supuestamente proporciona una precisión inesperadamente alta. En el ajuste excesivo, el modelo puede fallar al clasificar la variable debido a la confusión creada en la lógica debido a demasiadas condiciones. La técnica de eliminación hacia atrás reduce la característica extraña para evitar la situación de sobreajuste.

2. deméritos

Los deméritos de eliminación hacia atrás son los siguientes:

- En el método de eliminación hacia atrás, uno no puede descubrir qué predicador es responsable del rechazo de otro predicador debido a su alcance a la insignificancia. Por ejemplo, si el predicador X tiene algún significado que fue lo suficientemente bueno como para residir en un modelo después de agregar el predicador Y. Pero la importancia de X se vuelve obsoleta cuando otro predicador Z entra en el modelo. Por lo tanto, el algoritmo de eliminación hacia atrás no evidencia ninguna dependencia entre dos predictores que ocurre en la "técnica de selección hacia adelante".

- Después de descartar cualquier característica de un modelo mediante un algoritmo de eliminación hacia atrás, esa característica no se puede volver a seleccionar. En resumen, la eliminación hacia atrás no tiene un enfoque flexible para agregar o eliminar funciones / predictores.

- Las normas para seleccionar el valor de significancia (0.06) en el modelo son inflexibles. La eliminación hacia atrás no tiene un procedimiento flexible para no solo elegir sino también cambiar el valor insignificante según sea necesario para obtener el mejor ajuste en un conjunto de datos adecuado.

Conclusión

La técnica de eliminación hacia atrás se realizó para mejorar el rendimiento del modelo y optimizar su complejidad. Se usa vívidamente en regresiones múltiples donde el modelo trata con el extenso conjunto de datos. Es un enfoque fácil y simple en comparación con la selección directa y la validación cruzada en la que se encuentra la sobrecarga de optimización. La técnica de eliminación hacia atrás inicia la eliminación de características de mayor valor de significación. Su objetivo básico es hacer que el modelo sea menos complejo y prohibir la situación de ajuste excesivo.

Artículos recomendados

Esta es una guía para la eliminación hacia atrás. Aquí discutimos cómo aplicar la eliminación hacia atrás junto con los méritos y deméritos. También puede consultar los siguientes artículos para obtener más información.

- Aprendizaje automático de hiperparámetros

- Agrupación en Machine Learning

- máquina virtual de Java

- Aprendizaje automático sin supervisión