¿Qué es el Hadoop?

Antes de comprender las ventajas de Hadoop, primero comprenda Hadoop. Hadoop es un paradigma de procesamiento de grandes datos que proporciona un lugar confiable y escalable para el almacenamiento y procesamiento de datos. Hadoop fue creado por Doug Cutting y es considerado como el "Padre de Hadoop". Hadoop era el nombre del elefante de juguete de su hijo. Hadoop tuvo sus raíces en el Proyecto Nutch Search Engine. Hadoop es un marco de procesamiento que trajo enormes cambios en la forma en que procesamos los datos, la forma en que almacenamos los datos. En comparación con las herramientas de procesamiento tradicionales como RDBMS, Hadoop demostró que podemos combatir eficazmente los desafíos de Big data como,

Variedad de datos: Hadoop puede almacenar y procesar formatos de datos estructurados y semiestructurados y no estructurados.

El volumen de datos : Hadoop está especialmente diseñado para manejar el gran volumen de datos en el rango de petabytes.

La velocidad de los datos : Hadoop puede procesar petabytes de datos con alta velocidad en comparación con otras herramientas de procesamiento como RDBMS, es decir, el tiempo de procesamiento en Hadoop es muy menor.

Características destacadas de Hadoop

- Hadoop es de código abierto en la naturaleza.

- Funciona en un grupo de máquinas. El tamaño del clúster depende de los requisitos.

- Se puede ejecutar en hardware normal.

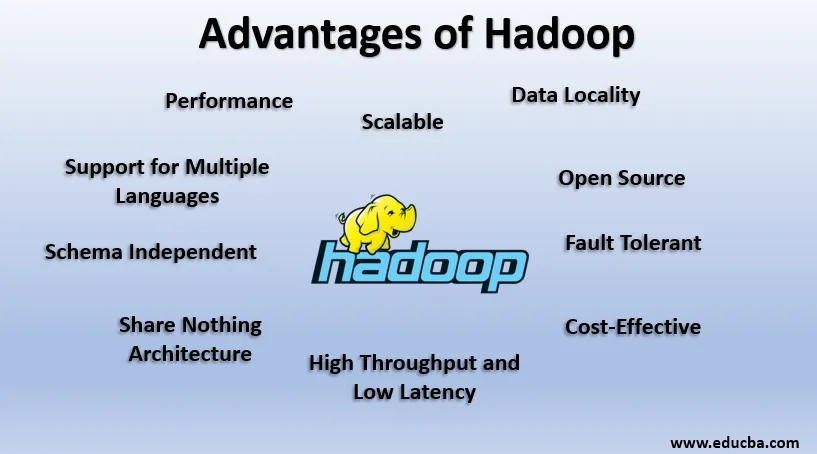

Ventajas de Hadoop

En esta sección, se discuten las ventajas de Hadoop. Ahora echemos un vistazo a ellos uno por uno:

1. Código abierto

Hadoop es de código abierto en la naturaleza, es decir, su código fuente está disponible gratuitamente. Podemos modificar el código fuente según nuestros requisitos comerciales. Incluso las versiones propietarias de Hadoop como trabajos de Cloudera y Horton también están disponibles.

2. Escalable

Hadoop trabaja en el grupo de máquinas. Hadoop es altamente escalable. Podemos aumentar el tamaño de nuestro clúster agregando nuevos nodos según los requisitos sin ningún tiempo de inactividad. Esta forma de agregar nuevas máquinas al clúster se conoce como Escalado horizontal, mientras que el aumento de componentes como duplicar el disco duro y la RAM se conoce como Escalado vertical.

3. Tolerante a fallas

La tolerancia a fallas es la característica más destacada de Hadoop. Por defecto, cada bloque en HDFS tiene un factor de replicación de 3. Para cada bloque de datos, HDFS crea dos copias más y las almacena en una ubicación diferente en el clúster. Si algún bloque se pierde debido a una falla de la máquina, todavía tenemos dos copias más del mismo bloque y se usan. De esta forma, se logra la tolerancia a fallos en Hadoop.

4. Esquema independiente

Hadoop puede trabajar en diferentes tipos de datos. Es lo suficientemente flexible como para almacenar varios formatos de datos y puede funcionar tanto en datos con esquema (estructurado) como sin esquema (no estructurado).

5. Alto rendimiento y baja latencia

El rendimiento significa la cantidad de trabajo realizado por unidad de tiempo y Baja latencia significa procesar los datos sin demora o menos demora. Como Hadoop se rige por el principio del almacenamiento distribuido y el procesamiento paralelo, el procesamiento se realiza simultáneamente en cada bloque de datos e independientemente uno del otro. Además, en lugar de mover datos, el código se mueve a datos en el clúster. Estos dos contribuyen a alto rendimiento y baja latencia.

6. Localidad de datos

Hadoop funciona según el principio de "Mover el código, no los datos". En Hadoop, los datos permanecen estacionarios y para el procesamiento de datos, el código se mueve a los datos en forma de tareas, esto se conoce como localidad de datos. Como estamos tratando con datos en el rango de petabytes, resulta difícil y costoso mover los datos a través de la red, la localidad de datos garantiza que el movimiento de datos en el clúster sea mínimo.

7. Rendimiento

En sistemas heredados como RDBMS, los datos se procesan secuencialmente, pero en el procesamiento de Hadoop comienza en todos los bloques a la vez, lo que proporciona un procesamiento paralelo. Debido a las técnicas de procesamiento en paralelo, el rendimiento de Hadoop es mucho mayor que los sistemas heredados como RDBMS. En 2008, Hadoop incluso derrotó al Supercomputador más rápido presente en ese momento.

8. Arquitectura Share Nothing

Cada nodo en el clúster de Hadoop es independiente el uno del otro. No comparten recursos ni almacenamiento, esta arquitectura se conoce como arquitectura Share Nothing (SN). Si falla un nodo en el clúster, no derribará todo el clúster ya que todos y cada uno de los nodos actúan de forma independiente, eliminando así un solo punto de falla.

9. Soporte para múltiples idiomas

Aunque Hadoop se desarrolló principalmente en Java, extiende el soporte para otros lenguajes como Python, Ruby, Perl y Groovy.

10. Rentable

Hadoop es de naturaleza muy económica. Podemos construir un clúster de Hadoop utilizando hardware normal, reduciendo así los costos de hardware. Según la era de la nube, los costos de gestión de datos de Hadoop, es decir, tanto el hardware como el software y otros gastos son muy mínimos en comparación con los sistemas ETL tradicionales.

11. abstracción

Hadoop proporciona abstracción en varios niveles. Facilita el trabajo a los desarrolladores. Un archivo grande se divide en bloques del mismo tamaño y se almacena en diferentes ubicaciones del clúster. Al crear la tarea de reducción de mapas, debemos preocuparnos por la ubicación de los bloques. Proporcionamos un archivo completo como entrada y el marco Hadoop se encarga del procesamiento de varios bloques de datos que se encuentran en diferentes ubicaciones. Hive es parte del ecosistema Hadoop y es una abstracción sobre Hadoop. Como las tareas de Map-Reduce están escritas en Java, los desarrolladores de SQL de todo el mundo no pudieron aprovechar Map Reduce. Entonces, Hive se presenta para resolver este problema. Podemos escribir SQL como consultas en Hive, lo que a su vez desencadena trabajos de reducción de mapas. Entonces, debido a Hive, la comunidad SQL también puede trabajar en Map Reduce Tasks.

12. compatibilidad

En Hadoop, HDFS es la capa de almacenamiento y Map Reduce es el motor de procesamiento. Pero, no existe una regla rígida de que Map Reduce sea el motor de procesamiento predeterminado. Los nuevos marcos de procesamiento como Apache Spark y Apache Flink utilizan HDFS como sistema de almacenamiento. Incluso en Hive también podemos cambiar nuestro motor de ejecución a Apache Tez o Apache Spark según nuestro requisito. Apache HBase, que es NoSQL Columnar Database, utiliza HDFS para la capa de almacenamiento.

13. Soporte para varios sistemas de archivos

Hadoop es de naturaleza muy flexible. Puede ingerir varios formatos de datos como imágenes, videos, archivos, etc. También puede procesar datos estructurados y no estructurados. Hadoop admite varios sistemas de archivos como JSON, XML, Avro, Parquet, etc.

Trabajo de Hadoop

A continuación se muestran los puntos que muestran cómo funciona Hadoop:

1. Almacenamiento distribuido y procesamiento paralelo

Este es el principio fundamental de todos los marcos del ecosistema Hadoop, incluido Apache Spark. Para comprender el funcionamiento de Hadoop y Spark, primero, debemos entender qué es "Almacenamiento distribuido y procesamiento paralelo".

2. Almacenamiento distribuido

Hadoop no almacena datos en una sola máquina, en cambio, divide esos enormes datos en bloques de igual tamaño que son 256 MB de forma predeterminada y almacena esos bloques en diferentes nodos de un clúster (nodos de trabajo). Almacena los metadatos de esos bloques en el nodo maestro. Esta forma de almacenar el archivo en ubicaciones distribuidas en un clúster se conoce como Sistema de archivos distribuidos de Hadoop - HDFS.

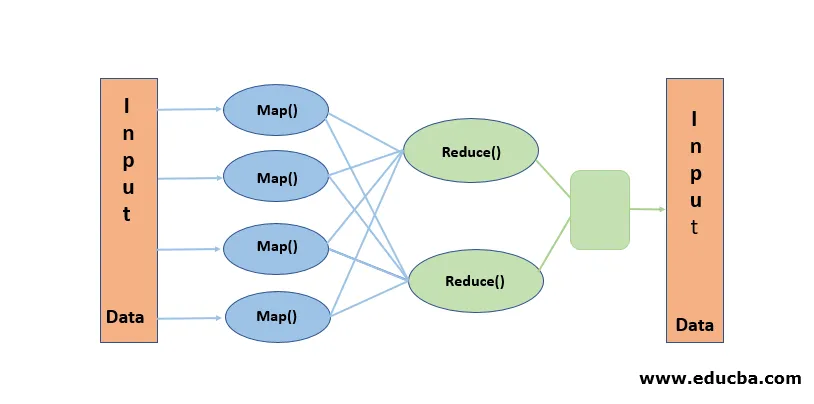

3. Procesamiento paralelo

Es un paradigma de procesamiento, donde el procesamiento se realiza simultáneamente en los bloques de datos almacenados en HDFS. El procesamiento en paralelo funciona con la noción de "Mover el código, no los datos". Los datos permanecen estacionarios en HDFS pero el código se mueve a los datos para su procesamiento. En términos simples, si nuestro archivo se divide en 100 bloques, se crean 100 copias del trabajo y viajan a través del clúster a la ubicación donde reside el bloque y el procesamiento en 100 bloques comienza simultáneamente (Fase de mapa). Los datos de salida de todos los bloques se recopilan y se reducen a la salida final (Fase de reducción). Map Reduce se considera el "corazón de Hadoop".

Conclusión-Ventajas de Hadoop

En esta era de los datos, Hadoop allanó el camino para un enfoque diferente a los desafíos planteados por Big data. Cuando decimos, Hadoop no nos referimos a Hadoop solo, incluye herramientas de ecosistema de Hadoop como Apache Hive que proporciona operaciones similares a SQL sobre Hadoop, Apache Pig, Apache HBase para la base de datos de almacenamiento en columnas, Apache Spark para el procesamiento en memoria y muchos más. Aunque Hadoop tiene sus propias desventajas, es altamente adaptable y evoluciona constantemente con cada lanzamiento.

Artículos recomendados

Esta es una guía de las ventajas de Hadoop. Aquí discutimos qué es Hadoop y las principales ventajas de Hadoop. También puede consultar nuestros otros artículos relacionados para obtener más información.

- Marco HADOOP

- ¿Qué es el clúster de Hadoop?

- ¿Qué es MapReduce en Hadoop?

- Base de datos de Hadoop

- ¿Qué es el Hadoop? El | Aplicaciones y características