Diferencia entre Apache Spark y Apache Flink

Apache Spark es un marco de cómputo de clúster de código abierto desarrollado por Apache Software. Apache Spark es muy rápido y puede usarse para el procesamiento de datos a gran escala. Es una alternativa para las herramientas de procesamiento de datos a gran escala existentes en el área de las tecnologías de big data. Apache Flink es un marco de código abierto para el procesamiento continuo de aplicaciones de transmisión de datos para alta disponibilidad, alto rendimiento, estabilidad y precisión en aplicaciones distribuidas. Apache Flink proporciona baja latencia, alto rendimiento en el motor de transmisión con tolerancia a fallas en el caso de falla del motor de datos o de la máquina.

Estudiemos mucho más sobre Apache Spark y Apache Flink en detalle:

- Spark es un marco de cómputo de clúster de código abierto desarrollado por Apache Software Foundation que fue desarrollado originalmente por la Universidad de California Berkeley y que más tarde fue donado a Apache Foundation para hacerlo de código abierto.

- Apache Flink es un marco de software de código abierto desarrollado por Apache Software Foundation. El componente principal de Flink es un motor distribuido de transmisión y procesamiento de datos que se escribió en Java y Scala.

- Apache Spark es muy rápido y se puede utilizar para el procesamiento de datos a gran escala, que está evolucionando muy bien hoy en día. Se ha convertido en una alternativa para muchas herramientas de procesamiento de datos a gran escala existentes en el área de las tecnologías de big data.

- Apache Spark se puede usar para ejecutar programas 100 veces más rápido que los trabajos de Map Reduce en el entorno de Hadoop, lo que lo hace más preferible. Spark también se puede ejecutar en la nube de Hadoop o Amazon AWS creando la instancia de Amazon EC2 (Elastic Cloud Compute) o el modo de clúster independiente y también puede acceder a diferentes bases de datos como Cassandra, Amazon Dynamo DB, etc.

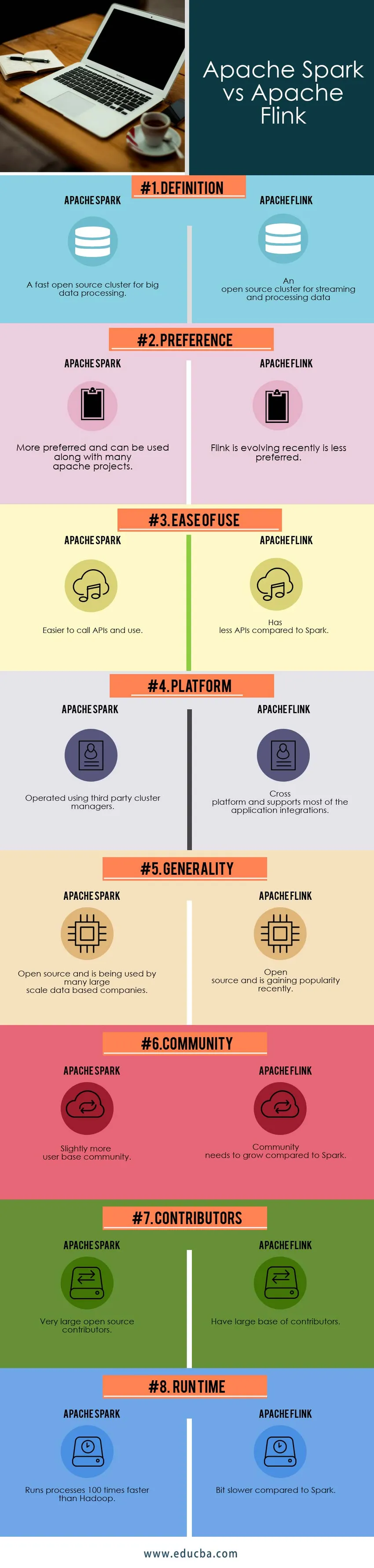

Comparación cabeza a cabeza entre Apache Spark y Apache Flink (infografía)

A continuación se muestra la comparación de los 8 principales entre Apache Spark y Apache Flink

Diferencias clave entre Apache Spark y Apache Flink

- Spark es un conjunto de interfaces de programación de aplicaciones (API) de todos los proyectos relacionados con Hadoop existentes más de 30. Apache Flink fue anteriormente un proyecto de investigación llamado Stratosphere antes de cambiar el nombre a Flink por sus creadores.

- Spark proporciona API de alto nivel en diferentes lenguajes de programación como Java, Python, Scala y R. En 2014 Apache Flink fue aceptado como Apache Incubator Project por Apache Projects Group.

- Spark tiene características centrales como Spark Core, Spark SQL, MLib (Machine Library), GraphX (para procesamiento de gráficos) y Spark Streaming y Flink se utiliza para realizar procesos cíclicos e iterativos iterando colecciones.

- Tanto Apache Spark como Apache Flink son plataformas de procesamiento de datos o transmisión de propósito general en el entorno de big data. El modo de clúster de chispa se puede usar para transmitir y procesar los datos en diferentes clústeres para datos a gran escala para procesar de forma rápida y paralela.

- El modo Spark Cluster tendrá aplicaciones que se ejecutan como procesos individuales en el clúster. Flink es una herramienta fuerte y de alto rendimiento para trabajos de procesamiento por lotes y procesos de programación de trabajos.

- Los componentes del clúster Spark son Driver Manager, Driver Program y Worker Nodes. Flink tiene otra característica de buen modo de compatibilidad para admitir diferentes proyectos de Apache, como la tormenta de Apache y el mapa para reducir los trabajos en su motor de ejecución para mejorar el rendimiento de transmisión de datos.

- Spark tiene diferentes tipos de administradores de clúster disponibles, como el administrador de clúster HADOOP Yarn, el modo independiente (ya mencionado anteriormente), Apache Mesos (un administrador general de clúster) y Kubernetes (experimental, que es un sistema de código abierto para la implementación de automatización). Flink solo tiene un motor de procesamiento de datos en comparación con Spark, que tiene diferentes componentes principales.

- Las funciones del componente de clúster de Spark tienen Tareas, Caché y Ejecutores dentro de un nodo de trabajo donde un administrador de clúster puede tener múltiples nodos de trabajo. La arquitectura Flink funciona de tal manera que las transmisiones no necesitan abrirse y cerrarse cada vez.

- Spark y Flink tienen administración en memoria. Spark bloquea el nodo cuando se queda sin memoria pero tiene tolerancia a fallas. Flink tiene un enfoque diferente para la gestión de la memoria. Flink escribe en el disco cuando se agota la memoria interna.

- Tanto Apache Spark como Apache Flink trabajan con el proyecto Apache Kafka desarrollado por LinkedIn, que también es una aplicación sólida de transmisión de datos con alta tolerancia a fallas.

- Spark puede compartir la capacidad de la memoria dentro de diferentes aplicaciones que residen en él, mientras que Flink tiene una gestión de memoria explícita que evita los picos ocasionales presentes en Apache Spark.

- Spark tiene más propiedades de configuración, mientras que Flink tiene menos propiedades de configuración.

- Flink puede aproximar las técnicas de procesamiento por lotes y Spark tiene un motor unificado que se puede ejecutar de forma independiente sobre Hadoop conectándose a muchos otros administradores de clúster y plataformas o servidores de almacenamiento.

- El uso de la red de Apache Spark es menor en el momento inicial del trabajo cuando se activa, lo que provoca un retraso en la ejecución de un trabajo. Apache Flink usa la red desde el principio, lo que indica que Flink usa sus recursos de manera efectiva.

- La menor utilización de recursos en Apache Spark causa menos productividad, mientras que en Apache Flunk la utilización de recursos es efectiva y la hace más productiva con mejores resultados.

Apache Spark vs Apache Flink Tabla de comparación

| BASE PARA

COMPARACIÓN | Apache Spark | Apache Flink |

| Definición | Un clúster rápido de código abierto para el procesamiento de big data | Un clúster de código abierto para transmitir y procesar datos. |

| Preferencia | Más preferido y puede usarse junto con muchos proyectos de Apache | Flink está evolucionando recientemente es menos preferido |

| Facilidad de uso | Es más fácil llamar a API y usar | Tiene menos API en comparación con Spark |

| Plataforma | Operado con administradores de clúster de terceros | Multiplataforma y admite la mayoría de las integraciones de aplicaciones |

| Generalidad | Código abierto y está siendo utilizado por muchas compañías basadas en datos a gran escala. | Código abierto y está ganando popularidad recientemente |

| Comunidad | Ligeramente más comunidad de usuarios | La comunidad necesita crecer en comparación con Spark |

| Contribuyentes | Colaboradores de código abierto muy grandes | Tener una gran base de contribuyentes |

| Tiempo de ejecución | Ejecuta procesos 100 veces más rápido que Hadoop | Un poco más lento en comparación con Spark |

Conclusión: Apache Spark vs Apache Flink

Apache Spark y Apache Flink son aplicaciones de procesamiento de flujo de datos de propósito general donde las API proporcionadas por ellos y la arquitectura y los componentes principales son diferentes. Spark tiene múltiples componentes principales para realizar diferentes requisitos de aplicación, mientras que Flink solo tiene capacidad de transmisión y procesamiento de datos.

Dependiendo de los requisitos comerciales, se puede elegir el marco de software. Spark existe desde hace unos años, mientras que Flink está evolucionando gradualmente hoy en día en la industria y hay posibilidades de que Apache Flink supere a Apache Spark.

Para integrarse con múltiples marcos, Spark es bastante preferido en comparación con Flink para soportar múltiples aplicaciones en un entorno distribuido.

Artículo recomendado

Esta ha sido una guía de Apache Spark vs Apache Flink, su significado, comparación directa, diferencias clave, tabla de comparación y conclusión. También puede consultar los siguientes artículos para obtener más información:

- Apache Hadoop vs Apache Spark | ¡Las 10 mejores comparaciones que debes conocer!

- Las mejores cosas que aprender sobre Apache Spark (Guía)

- Apache Storm vs Apache Spark - Aprende 15 diferencias útiles

- Las 15 mejores cosas que debes saber sobre MapReduce vs Spark