Introducción a los comandos de Hadoop fs

En este artículo, veremos los comandos de manejo de archivos de HADOOP, que se utiliza para administrar los archivos a través de la consola.

Necesitará un sistema Linux y la última versión de Hadoop. Para imprimir la versión de Hadoop, para saber por quién se creó el lanzamiento, el valor de suma de comprobación solo necesitamos ejecutar el siguiente comando después de iniciar sesión en la plataforma Hadoop.

Comando: versión de Hadoop

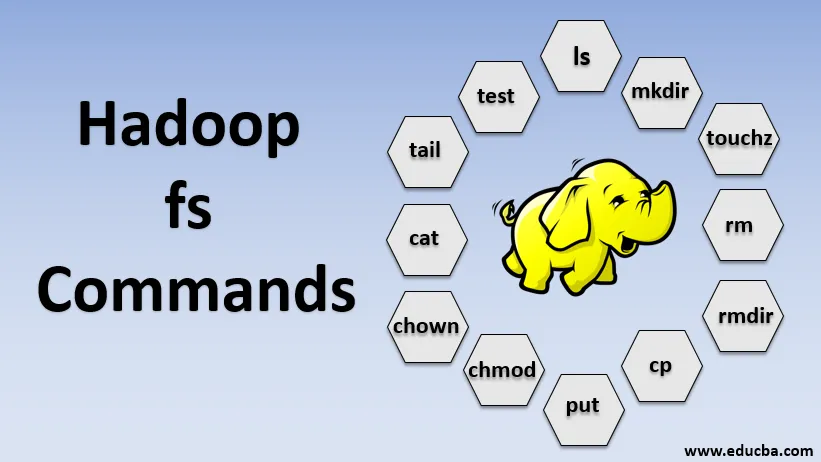

Comandos de Hadoop fs

Ahora, aprendamos cómo usar los comandos HADOOP fs.

Comenzaremos con lo básico. Simplemente escriba estos comandos en PUTTY o en cualquier consola con la que se sienta cómodo.

1. hadoop fs -ls

Para un directorio, devuelve la lista de archivos y directorios, mientras que, para un archivo, devuelve las estadísticas del archivo.

hadoop fs -lsr: esto es para enumerar recursivamente los directorios y archivos en carpetas específicas.

- Ejemplo : hadoop fs -ls / o hadoop fs -lsr

- -d: se utiliza para enumerar los directorios como archivos sin formato.

- -h: Esto se usa para formatear los tamaños de los archivos de una manera legible para las personas que no sea solo el número de bytes.

- -R: Esto se usa para enumerar recursivamente el contenido de los directorios.

2. hadoop fs -mkdir

Este comando toma la ruta como argumento y crea directorios en hdfs.

- Ejemplo : hadoop fs -mkdir / user / datahub1 / data

3. hadoop fs -touchz

Crea un archivo vacío y no utiliza espacio

- Ejemplo: hadoop fs -touchz URI

4. hadoop fs -rm

Eliminar archivos especificados como argumento. Debemos especificar la opción -r para eliminar todo el directorio. Y si se especifica la opción -skipTrash, omitirá la basura y el archivo se eliminará de inmediato.

- Ejemplo : hadoop fs -rm -r /user/test1/abc.text

5. hadoopfs -rmdir

Elimina archivos y permisos de directorios y subdirectorios. Básicamente es la versión ampliada de Hadoop fs -rm.

6. hadoop fs -cp

Copia el archivo de una ubicación a otra

- Ejemplo : hadoop fs -cp /user/data/abc.csv / user / datahub

7. hadoop fs -copyFromLocal

Copia el archivo de edgenode a HDFS.

8. hadoop fs -put

Copia el archivo de edgenode a HDFS, es similar al comando anterior pero también lee la entrada de la entrada estándar y escribe en HDFS

- Ejemplo : hadoop fs -put abc.csv / user / data

hadoop fs -put -p: el indicador conserva el acceso, el tiempo de modificación, la propiedad y el modo.

hadoop fs -put -f: este comando sobrescribe el destino si el archivo ya existe antes de la copia.

9. hadoop fs -moveFromLocal

Es similar a copiar desde local excepto que el archivo fuente se elimina del edgenodo local después de que se copia a HDFS

- Ejemplo : fs -moveFromLocal abc.text / user / data / acb.

10. hadoop fs -copyToLocal

Copia el archivo de HDFS a edgenode.

- Ejemplo : fs -copyToLocal abc.text / localpath

11. hadoop fs -chmod

Este comando nos ayuda a cambiar el acceso de un archivo o directorio

- Ejemplo : hadoop fs -chmod (-R) (ruta)

12. hadoop fs-chown

Este comando nos ayuda a cambiar la propiedad de un archivo o directorio

- Ejemplo : hadoop fs -chown (-R) (PROPIETARIO) (:( GRUPO)) RUTA

13. hadoop fs -cat

Imprime el contenido de un archivo HDFS en el terminal

- Ejemplo : hadoop fs -cat /user/data/abc.csv

14. hadoop fs -tail

Muestra la última KB del archivo HDFS en la salida estándar

- Ejemplo : hadoop fs -tail / in / xyzfile

15. hadoop fs -test

Este comando se usa para operaciones de prueba de archivos HDFS, devuelve 0 si es verdadero.

- - e: comprueba si el archivo existe.

- -z: comprueba si el archivo es de longitud cero

- -d / -f: comprueba si la ruta es directorio / archivo respectivamente

Aquí, discutimos un ejemplo en detalle

- Ejemplo : hadoop fs -test - (defz) /user/test/test1.text

16. hadoop fs -du

Muestra tamaños de archivos y directorios contenidos en el directorio dado o la longitud de un archivo en caso de que sea un archivo

17. hadoop fs -df

Muestra espacio libre

18. hadoop fs -checksum

Devuelve la información de suma de comprobación de un archivo

19. hadoop fs -getfacl

Muestra la lista de control de acceso (ACL) del archivo o directorio particular

20. hadoop fs -count

Cuenta la cantidad de directorios, archivos y bytes en la ruta que coincide con el patrón de archivo especificado.

21. hadoop fs -setrep

Cambia el factor de replicación de un archivo. Y si la ruta es un directorio, el comando cambia el factor de replicación de todos los archivos del directorio.

- Ejemplo : hadoop fs -setrep -R / user / datahub: se utiliza para aceptar la capacidad hacia atrás y no tiene ningún efecto.

hadoop fs - setrep -w / user / datahub : espera a que se complete la replicación

22. hadoop fs -getmerge

Concatena archivos HDFS en origen en el archivo local de destino

- Ejemplo : hadoop fs -getmerge / user / datahub

23. hadoop fs -appendToFile

Agrega una sola fuente o múltiples fuentes del sistema de archivos local al destino.

- Ejemplo : hadoop fs -appendToFile xyz.log data.csv / in / appendfile

24. hadoop fs -stat

Imprime las estadísticas sobre el archivo o directorio.

- Ejemplo : hadoop fs -stat (formato)

Conclusión - Comandos Hadoop fs

Por lo tanto, hemos revisado casi todos los comandos necesarios para el manejo de archivos y ver los datos dentro de los archivos. Puede modificar sus archivos e ingerir datos en la plataforma Hadoop ahora.

Artículos recomendados

Esta es una guía de los comandos de Hadoop fs. Aquí discutimos la introducción a los comandos de Hadoop fs junto con su ejemplo en detalle. También puede consultar los siguientes artículos para obtener más información.

- Instalar Hadoop

- Herramientas Hadoop

- Arquitectura Hadoop

- Componentes Hadoop

- Comandos Hadoop fs