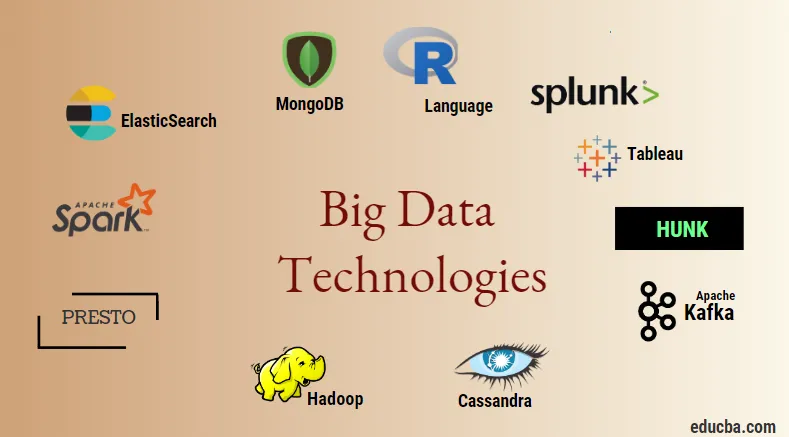

Introducción a las tecnologías de Big Data

La tecnología de Big Data y Hadoop es una gran palabra de moda como podría sonar. Como ha habido un gran aumento en el dominio de datos e información de cada industria y dominio, es muy importante establecer e introducir una técnica eficiente que se ocupe de todas las necesidades y requisitos de los clientes y las grandes industrias responsables de la generación de datos. . Anteriormente, los datos estaban siendo manejados por lenguajes de programación normales y lenguaje de consulta estructurado simple, pero ahora estos sistemas y herramientas no parecen hacer mucho en caso de grandes datos. La tecnología de Big Data se define como la tecnología y una utilidad de software que está diseñada para el análisis, procesamiento y extracción de la información de un gran conjunto de estructuras extremadamente complejas y grandes conjuntos de datos que es muy difícil de manejar para los sistemas tradicionales. La tecnología de Big Data se utiliza para manejar datos relacionados tanto en tiempo real como en lotes. El aprendizaje automático se ha convertido en un componente muy crítico de la vida cotidiana y de todas las industrias y, por lo tanto, la gestión de datos a través de big data se vuelve muy importante.

Tipos de tecnologías de Big Data

Antes de comenzar con la lista de tecnologías, veamos primero la amplia clasificación de todas estas tecnologías. Se pueden clasificar principalmente en 4 dominios.

- Almacenamiento de datos

- Analítica

- Procesamiento de datos

- Visualización

Primero cubramos todas las tecnologías que vienen bajo el paraguas de almacenamiento.

1. Hadoop : cuando se trata de big data, Hadoop es la primera tecnología que entra en juego. Esto se basa en la arquitectura de reducción de mapas y ayuda en el procesamiento de trabajos relacionados con lotes y procesa información de lotes. Fue diseñado para almacenar y procesar los datos en un entorno de procesamiento de datos distribuido junto con hardware básico y un modelo de ejecución de programación simple. Se puede usar para almacenar y analizar los datos presentes en varias máquinas diferentes con alto almacenamiento, velocidad y bajos costos. Este forma uno de los principales componentes principales de la tecnología de Big Data que fue desarrollada por la fundación de software Apache en el año 2011 y está escrita en Java.

1. Hadoop : cuando se trata de big data, Hadoop es la primera tecnología que entra en juego. Esto se basa en la arquitectura de reducción de mapas y ayuda en el procesamiento de trabajos relacionados con lotes y procesa información de lotes. Fue diseñado para almacenar y procesar los datos en un entorno de procesamiento de datos distribuido junto con hardware básico y un modelo de ejecución de programación simple. Se puede usar para almacenar y analizar los datos presentes en varias máquinas diferentes con alto almacenamiento, velocidad y bajos costos. Este forma uno de los principales componentes principales de la tecnología de Big Data que fue desarrollada por la fundación de software Apache en el año 2011 y está escrita en Java.

2. MongoDB : Otro componente esencial y esencial de la tecnología de big data en términos de almacenamiento es la base de datos MongoDB NoSQL. Es una base de datos NoSQL, lo que significa que las propiedades relacionales y otras propiedades relacionadas con RDBMS no se aplican a ella. Es diferente de las bases de datos RDBMS tradicionales que utilizan lenguaje de consulta estructurado. Utiliza documentos de esquema y la estructura del almacenamiento de datos también es diferente y, por lo tanto, son útiles para mantener una gran cantidad de datos. Es un diseño multiplataforma orientado a documentos y un programa de base de datos que hace uso de documentos similares a JSON junto con el esquema. Esto se convierte en un caso de uso muy útil de los almacenes de datos operativos en la mayoría de las instituciones financieras y, por lo tanto, trabajando para reemplazar los mainframes tradicionales. MongoDB maneja la flexibilidad y también una amplia variedad de tipos de datos en grandes volúmenes y entre arquitecturas distribuidas.

2. MongoDB : Otro componente esencial y esencial de la tecnología de big data en términos de almacenamiento es la base de datos MongoDB NoSQL. Es una base de datos NoSQL, lo que significa que las propiedades relacionales y otras propiedades relacionadas con RDBMS no se aplican a ella. Es diferente de las bases de datos RDBMS tradicionales que utilizan lenguaje de consulta estructurado. Utiliza documentos de esquema y la estructura del almacenamiento de datos también es diferente y, por lo tanto, son útiles para mantener una gran cantidad de datos. Es un diseño multiplataforma orientado a documentos y un programa de base de datos que hace uso de documentos similares a JSON junto con el esquema. Esto se convierte en un caso de uso muy útil de los almacenes de datos operativos en la mayoría de las instituciones financieras y, por lo tanto, trabajando para reemplazar los mainframes tradicionales. MongoDB maneja la flexibilidad y también una amplia variedad de tipos de datos en grandes volúmenes y entre arquitecturas distribuidas.

3. Hunk : es útil para acceder a los datos a través de clústeres remotos de Hadoop mediante el uso de índices virtuales y también utiliza el lenguaje de procesamiento de búsqueda Splunk que se puede utilizar para el análisis de datos. El trozo se puede utilizar para informar y visualizar grandes cantidades de datos de las bases de datos y fuentes Hadoop y NoSQL. Fue desarrollado por el equipo Splunk en el año 2013 que fue escrito en Java.

3. Hunk : es útil para acceder a los datos a través de clústeres remotos de Hadoop mediante el uso de índices virtuales y también utiliza el lenguaje de procesamiento de búsqueda Splunk que se puede utilizar para el análisis de datos. El trozo se puede utilizar para informar y visualizar grandes cantidades de datos de las bases de datos y fuentes Hadoop y NoSQL. Fue desarrollado por el equipo Splunk en el año 2013 que fue escrito en Java.

4. Cassandra : Cassandra forma una de las mejores opciones entre la lista de bases de datos NoSQL populares que es una base de datos gratuita y de código abierto, que se distribuye y tiene un amplio almacenamiento en columnas y puede manejar de manera eficiente los datos en grandes grupos de productos básicos, es decir, se utiliza para Proporcionar alta disponibilidad junto con un único punto de falla. Entre la lista de características principales se incluyen las de naturaleza distribuida, escalabilidad, mecanismo tolerante a fallas, compatibilidad con MapReduce, consistencia ajustable, propiedad del lenguaje de consulta, admite replicación de centros de datos múltiples y consistencia eventual.

4. Cassandra : Cassandra forma una de las mejores opciones entre la lista de bases de datos NoSQL populares que es una base de datos gratuita y de código abierto, que se distribuye y tiene un amplio almacenamiento en columnas y puede manejar de manera eficiente los datos en grandes grupos de productos básicos, es decir, se utiliza para Proporcionar alta disponibilidad junto con un único punto de falla. Entre la lista de características principales se incluyen las de naturaleza distribuida, escalabilidad, mecanismo tolerante a fallas, compatibilidad con MapReduce, consistencia ajustable, propiedad del lenguaje de consulta, admite replicación de centros de datos múltiples y consistencia eventual.

A continuación, hablemos sobre los diferentes campos de la tecnología de big data, es decir, Data Mining.

5. Presto : es un popular motor de consultas distribuidas de código abierto y basado en SQL que se utiliza para ejecutar consultas interactivas contra las fuentes de datos de cada escala y los rangos de tamaño de Gigabytes a Petabytes. Con su ayuda, podemos consultar datos en Cassandra, Hive, almacenes de datos patentados y sistemas de almacenamiento de bases de datos relacionales. Este es un motor de consulta basado en Java que fue desarrollado por la fundación Apache en el año 2013. Algunos grupos de empresas que están haciendo un buen uso de la herramienta Presto son Netflix, Airbnb, Checkr, Repro y Facebook.

5. Presto : es un popular motor de consultas distribuidas de código abierto y basado en SQL que se utiliza para ejecutar consultas interactivas contra las fuentes de datos de cada escala y los rangos de tamaño de Gigabytes a Petabytes. Con su ayuda, podemos consultar datos en Cassandra, Hive, almacenes de datos patentados y sistemas de almacenamiento de bases de datos relacionales. Este es un motor de consulta basado en Java que fue desarrollado por la fundación Apache en el año 2013. Algunos grupos de empresas que están haciendo un buen uso de la herramienta Presto son Netflix, Airbnb, Checkr, Repro y Facebook.

6. ElasticSearch : esta es una herramienta muy importante hoy en día cuando se trata de buscar. Esto forma un componente esencial de la pila ELK, es decir, la búsqueda elástica, Logstash y Kibana. ElasticSearch es un motor de búsqueda basado en la biblioteca Lucene que es similar a Solr y se utiliza para proporcionar un motor de búsqueda de texto completo puramente distribuido que es capaz de múltiples inquilinos. Tiene una lista de documentos JSON sin esquema y una interfaz web HTTP. Está escrito en el lenguaje JAVA y es desarrollado por Elastic Company en la compañía 2012. Los nombres de algunas compañías que hacen uso de Elasticsearch son: LinkedIn, StackOverflow, Netflix, Facebook, Google, Accenture, etc.

6. ElasticSearch : esta es una herramienta muy importante hoy en día cuando se trata de buscar. Esto forma un componente esencial de la pila ELK, es decir, la búsqueda elástica, Logstash y Kibana. ElasticSearch es un motor de búsqueda basado en la biblioteca Lucene que es similar a Solr y se utiliza para proporcionar un motor de búsqueda de texto completo puramente distribuido que es capaz de múltiples inquilinos. Tiene una lista de documentos JSON sin esquema y una interfaz web HTTP. Está escrito en el lenguaje JAVA y es desarrollado por Elastic Company en la compañía 2012. Los nombres de algunas compañías que hacen uso de Elasticsearch son: LinkedIn, StackOverflow, Netflix, Facebook, Google, Accenture, etc.

Ahora, leamos sobre todas esas tecnologías de big data que forman parte del análisis de datos:

7. Apache Kafka : Conocido por su publicación-suscripción o pub-sub, como se le conoce popularmente, es un sistema de mensajería asíncrona de mensajería directa que se utiliza para ingerir y procesar datos en tiempo real. También proporciona una provisión del período de retención y los datos pueden canalizarse por medio del mecanismo productor-consumidor. Es una de las plataformas de transmisión más populares que es muy similar al sistema de mensajería empresarial o una cola de mensajería. Kafka ha lanzado muchas mejoras hasta la fecha y una de las principales es la confluente de Kafka, que proporciona un nivel adicional de propiedades a Kafka, como el registro de esquema, Ktables, KSql, etc. Fue desarrollada por la comunidad de Apache Software en el año 2011 y Está escrito en Java. Las empresas que están haciendo uso de esta tecnología incluyen Twitter, Spotify, Netflix, Linkedin, Yahoo, etc.

7. Apache Kafka : Conocido por su publicación-suscripción o pub-sub, como se le conoce popularmente, es un sistema de mensajería asíncrona de mensajería directa que se utiliza para ingerir y procesar datos en tiempo real. También proporciona una provisión del período de retención y los datos pueden canalizarse por medio del mecanismo productor-consumidor. Es una de las plataformas de transmisión más populares que es muy similar al sistema de mensajería empresarial o una cola de mensajería. Kafka ha lanzado muchas mejoras hasta la fecha y una de las principales es la confluente de Kafka, que proporciona un nivel adicional de propiedades a Kafka, como el registro de esquema, Ktables, KSql, etc. Fue desarrollada por la comunidad de Apache Software en el año 2011 y Está escrito en Java. Las empresas que están haciendo uso de esta tecnología incluyen Twitter, Spotify, Netflix, Linkedin, Yahoo, etc.

8. Splunk : Splunk se utiliza para capturar, correlacionar e indexar datos de transmisión en tiempo real desde un repositorio de búsqueda desde donde puede generar informes, gráficos, paneles, alertas y visualizaciones de datos. También se utiliza para la seguridad, el cumplimiento y la gestión de aplicaciones y también para el análisis web, generando información comercial y análisis empresarial. Fue desarrollado por Splunk en Python, XML, Ajax.

8. Splunk : Splunk se utiliza para capturar, correlacionar e indexar datos de transmisión en tiempo real desde un repositorio de búsqueda desde donde puede generar informes, gráficos, paneles, alertas y visualizaciones de datos. También se utiliza para la seguridad, el cumplimiento y la gestión de aplicaciones y también para el análisis web, generando información comercial y análisis empresarial. Fue desarrollado por Splunk en Python, XML, Ajax.

9. Apache Spark : ahora viene la tecnología más crítica y más esperada en el dominio de las tecnologías de Big Data, es decir, Apache Spark. Posiblemente se encuentre entre los que tienen mayor demanda en la actualidad y utiliza Java, Scala o Python para su procesamiento. Esto se utiliza para procesar y manejar los datos de transmisión en tiempo real mediante el uso de Spark Streaming, que utiliza operaciones de procesamiento por lotes y ventanas para hacer que eso suceda. Spark SQL se utiliza para crear marcos de datos, conjuntos de datos sobre RDD y, por lo tanto, proporciona un buen sabor de transformaciones y acciones que forman un componente integral de Apache Spark Core. Otros componentes como Spark Mllib, R y graphX también son útiles en el caso de análisis y aprendizaje automático y ciencia de datos. La técnica de computación en memoria es lo que lo hace diferente de otras herramientas y componentes y admite una amplia variedad de aplicaciones. Fue desarrollado principalmente por la fundación Apache Software en lenguaje Java.

9. Apache Spark : ahora viene la tecnología más crítica y más esperada en el dominio de las tecnologías de Big Data, es decir, Apache Spark. Posiblemente se encuentre entre los que tienen mayor demanda en la actualidad y utiliza Java, Scala o Python para su procesamiento. Esto se utiliza para procesar y manejar los datos de transmisión en tiempo real mediante el uso de Spark Streaming, que utiliza operaciones de procesamiento por lotes y ventanas para hacer que eso suceda. Spark SQL se utiliza para crear marcos de datos, conjuntos de datos sobre RDD y, por lo tanto, proporciona un buen sabor de transformaciones y acciones que forman un componente integral de Apache Spark Core. Otros componentes como Spark Mllib, R y graphX también son útiles en el caso de análisis y aprendizaje automático y ciencia de datos. La técnica de computación en memoria es lo que lo hace diferente de otras herramientas y componentes y admite una amplia variedad de aplicaciones. Fue desarrollado principalmente por la fundación Apache Software en lenguaje Java.

10. Lenguaje R : R es un lenguaje de programación y un entorno de software libre que se utiliza para computación estadística y también para gráficos en uno de los idiomas más importantes de R. Este es uno de los lenguajes más populares entre los científicos de datos, mineros de datos y profesionales de datos para el desarrollo de software estadístico y principalmente en análisis de datos.

10. Lenguaje R : R es un lenguaje de programación y un entorno de software libre que se utiliza para computación estadística y también para gráficos en uno de los idiomas más importantes de R. Este es uno de los lenguajes más populares entre los científicos de datos, mineros de datos y profesionales de datos para el desarrollo de software estadístico y principalmente en análisis de datos.

Discutamos ahora las tecnologías relacionadas con la visualización de datos.

11. Tableau: es la herramienta de visualización de datos de crecimiento más rápido y potente que se utiliza en el dominio de inteligencia empresarial. El análisis de datos es una máquina muy rápida que es posible con la ayuda de Tableau y las visualizaciones se crean en forma de hojas de trabajo y paneles. Fue desarrollado por la compañía Tableau en el año 2013 y está escrito en Python, C ++, Java y C. Las compañías que utilizan Tableau son: QlikQ, Oracle Hyperion, Cognos, etc.

11. Tableau: es la herramienta de visualización de datos de crecimiento más rápido y potente que se utiliza en el dominio de inteligencia empresarial. El análisis de datos es una máquina muy rápida que es posible con la ayuda de Tableau y las visualizaciones se crean en forma de hojas de trabajo y paneles. Fue desarrollado por la compañía Tableau en el año 2013 y está escrito en Python, C ++, Java y C. Las compañías que utilizan Tableau son: QlikQ, Oracle Hyperion, Cognos, etc.

12. Plotly : Plotly se usa principalmente para hacer que los gráficos y los componentes asociados sean más rápidos y eficientes. Tiene un conjunto más rico de bibliotecas y API como MATLAB, Python, R, Arduino, Julia, etc. Esto se puede usar de forma interactiva en Jupyter notebook y Pycharm y se puede usar para diseñar gráficos interactivos. Fue desarrollado por primera vez en 2012 y escrito en JavaScript. Las pocas compañías que usan Plotly son paladines, bitbank, etc.

12. Plotly : Plotly se usa principalmente para hacer que los gráficos y los componentes asociados sean más rápidos y eficientes. Tiene un conjunto más rico de bibliotecas y API como MATLAB, Python, R, Arduino, Julia, etc. Esto se puede usar de forma interactiva en Jupyter notebook y Pycharm y se puede usar para diseñar gráficos interactivos. Fue desarrollado por primera vez en 2012 y escrito en JavaScript. Las pocas compañías que usan Plotly son paladines, bitbank, etc.

Conclusión

En esta publicación, hemos estudiado las principales tecnologías de big data que se utilizan ampliamente en la actualidad. Espero que les haya gustado. Sigue siguiéndonos para más publicaciones como estas.

Artículos recomendados

Esta es una guía de las tecnologías de Big Data. Aquí hemos discutido una introducción y tipos de Tecnologías de Big Data. También puede consultar nuestros otros artículos sugeridos para obtener más información:

- ¿Qué es la herramienta Splunk?

- R vs Python

- ¿Qué es matlab?

- ¿Qué es MongoDB?

- Pasos a seguir en las pruebas de mainframe

- Tipos de combinaciones en Spark SQL (ejemplos)

- Aprenda los diferentes tipos de herramientas Kafka