¿Qué es la tecnología Big Data?

Como sabemos, los datos evolucionan constantemente. El crecimiento de los datos ha desafiado a las mentes humanas a extraer, analizar y lidiar con eso. Esto se debe a que las formas tradicionales de tratar con los datos no son compatibles con estos grandes datos. Los datos grandes se describen generalmente por tres conceptos: volumen, variedad y velocidad.

Los datos se han convertido en el activo más importante de todas las empresas. Analizar estos grandes datos ayuda a la empresa a analizar el comportamiento de sus clientes y predecir cosas relevantes asociadas con las decisiones basadas en datos que hacen que la organización, tome medidas más seguras y desarrolle estrategias más sólidas.

Conociendo el ritmo con el que aumentan los datos en la era actual, los grandes datos serán un campo gigante en el futuro cercano para trabajar. Se necesitarán todos los estudiantes, principiantes y profesionales para mantenerse al día con las tecnologías emergentes de big data. Mantenerse actualizado traerá una carrera excelente y exitosa en el camino profesional.

Tecnologías de Big Data

Aquí estoy enumerando algunas tecnologías de big data con una explicación lúcida para informarle sobre las próximas tendencias y tecnología:

-

Apache Spark:

Es un motor de procesamiento de datos grandes y rápido. Esto se construye teniendo en cuenta el procesamiento de datos en tiempo real. Su rica biblioteca de aprendizaje automático es buena para trabajar en el espacio de IA y ML. Procesa datos en paralelo y en equipos agrupados. El tipo de datos básico utilizado por Spark es RDD (conjunto de datos distribuidos resilientes).

-

Bases de datos NoSQL:

Son las bases de datos no relacionales las que proporcionan un almacenamiento y recuperación rápidos de datos. Su capacidad para manejar todo tipo de datos, como datos estructurados, semiestructurados, no estructurados y polimórficos, es única. No hay bases de datos SQL de los siguientes tipos:

- Bases de datos de documentos : almacena datos en forma de documentos que pueden contener muchos pares clave-valor diferentes.

- Almacenes de gráficos : almacena datos que generalmente se almacenan en forma de red, como datos de redes sociales.

- Almacenes de valores clave : Estas son las bases de datos NoSQL más simples. Todos y cada uno de los elementos de la base de datos se almacenan como un nombre de atributo (o 'clave'), junto con su valor.

- Almacenes de columna ancha : esta base de datos almacena datos en formato de columnas en lugar de formato basado en filas. Cassandra y HBase son buenos ejemplos de ello.

-

Apache Kafka:

Kafka es una plataforma de transmisión de eventos distribuidos que maneja muchos eventos todos los días. Como es rápido y escalable, esto es útil para construir canalizaciones de datos de transmisión en tiempo real que recuperen datos de manera confiable entre sistemas o aplicaciones.

-

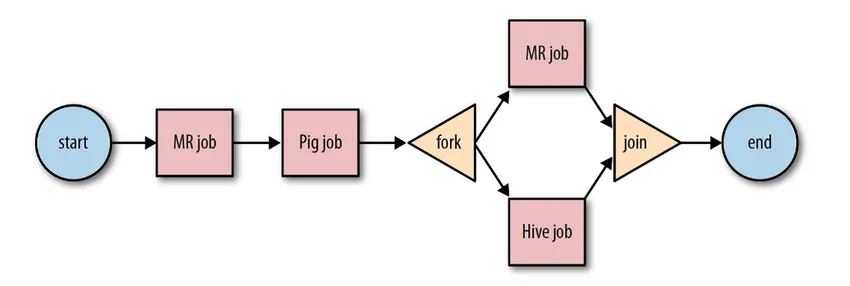

Apache Oozie:

Es un sistema de planificador de flujo de trabajo para administrar trabajos de Hadoop. Estos trabajos de flujo de trabajo se programan en forma de gráficos acíclicos dirigidos (DAG) para acciones.

Fuente: Google

Su solución escalable y organizada para actividades de big data.

-

Flujo de aire de Apache:

Esta es una plataforma que programa y monitorea el flujo de trabajo. La programación inteligente ayuda a organizar y ejecutar el proyecto de manera eficiente. Airflow posee la capacidad de volver a ejecutar una instancia de DAG cuando hay una instancia de falla. Su rica interfaz de usuario facilita la visualización de las tuberías que se ejecutan en varias etapas, como producción, supervisar el progreso y solucionar problemas cuando sea necesario.

-

Haz de Apache:

Es un modelo unificado, para definir y ejecutar canales de procesamiento de datos que incluyen ETL y transmisión continua. El marco Apache Beam proporciona una abstracción entre la lógica de su aplicación y el ecosistema de big data, ya que no existe una API que enlace todos los marcos como Hadoop, spark, etc.

-

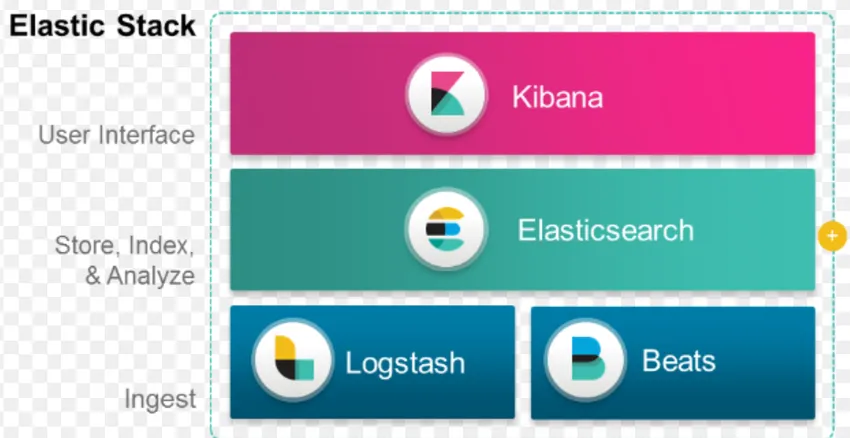

Pila ELK:

ELK es conocido por Elasticsearch, Logstash y Kibana.

Elasticsearch es una base de datos sin esquema (que indexa cada campo) que tiene capacidades de búsqueda poderosas y fácilmente escalables.

Logstash es una herramienta ETL que nos permite buscar, transformar y almacenar eventos en Elasticsearch.

Kibana es una herramienta de tablero para Elasticsearch, donde puede analizar todos los datos almacenados. La información práctica extraída de Kibana ayuda a construir estrategias para una organización. Desde la captura de cambios hasta la predicción, Kibana siempre ha demostrado ser muy útil.

-

Docker y Kubernete:

Estas son las tecnologías emergentes que ayudan a las aplicaciones a ejecutarse en contenedores Linux. Docker es una colección de herramientas de código abierto que te ayuda a "Construir, enviar y ejecutar cualquier aplicación, en cualquier lugar".

Kubernetes también es una plataforma de orquestación / contenedor de código abierto, que permite que grandes cantidades de contenedores trabajen juntos en armonía. Esto finalmente reduce la carga operativa.

-

TensorFlow:

Es una biblioteca de aprendizaje automático de código abierto que se utiliza para diseñar, construir y entrenar modelos de aprendizaje profundo. Todos los cálculos se realizan en TensorFlow con gráficos de flujo de datos. Los gráficos comprenden nodos y aristas. Los nodos representan operaciones matemáticas, mientras que los bordes representan los datos.

TensorFlow es útil para la investigación y la producción. Se ha creado teniendo en cuenta que podría ejecutarse en múltiples CPU o GPU e incluso en sistemas operativos móviles. Esto podría implementarse en Python, C ++, R y Java.

-

Presto:

Presto es un motor SQL de código abierto desarrollado por Facebook, que es capaz de manejar petabytes de datos. A diferencia de Hive, Presto no depende de la técnica MapReduce y, por lo tanto, es más rápido para recuperar los datos. Su arquitectura e interfaz son lo suficientemente fáciles de interactuar con otros sistemas de archivos.

Debido a la baja latencia y la consulta interactiva fácil, se está volviendo muy popular hoy en día para manejar grandes datos.

-

Polybase:

Polybase funciona sobre SQL Server para acceder a los datos almacenados en PDW (Parallel Data Warehouse). PDW creado para procesar cualquier volumen de datos relacionales y proporciona integración con Hadoop.

-

Colmena:

Hive es una plataforma utilizada para consultas de datos y análisis de datos en grandes conjuntos de datos. Proporciona un lenguaje de consulta similar a SQL llamado HiveQL, que internamente se convierte en MapReduce y luego se procesa.

Con el rápido crecimiento de los datos y el gran esfuerzo de la organización por analizar los grandes datos, la tecnología ha introducido tantas tecnologías maduras en el mercado que conocerlas es de gran beneficio. Hoy en día, la tecnología de Big Data está abordando muchas necesidades y problemas comerciales, al aumentar la eficiencia operativa y predecir el comportamiento relevante. Una carrera en big data y su tecnología relacionada puede abrir muchas puertas de oportunidades tanto para la persona como para las empresas.

De ahora en adelante, es hora de adoptar tecnologías de big data.

Artículos recomendados

Esta ha sido una guía de Qué es la tecnología Big Data. Aquí hemos discutido algunas tecnologías de big data como Hive, Apache Kafka, Apache Beam, ELK Stack, etc. También puede consultar el siguiente artículo para obtener más información:

- ¿Qué es el aprendizaje profundo?

- Guía de Minitab?

- ¿Qué es la tecnología Salesforce?

- ¿Qué es el análisis de Big Data?