Diferencia entre Datos pequeños y datos grandes

Small Data, no es más que los datos que son lo suficientemente pequeños y completos para humanos en un volumen y también para formatear, lo que los hace accesibles, informativos y procesables. El procesamiento de datos tradicional no puede tratar con datos grandes o complejos, estos datos se denominan Big Data. Cuando el volumen de datos crece más allá de cierto límite, los sistemas y metodologías tradicionales no son suficientes para procesar datos o transformarlos en un formato útil. Esta es la razón por la cual los datos generalmente se clasifican en dos: Small Data vs Big Data

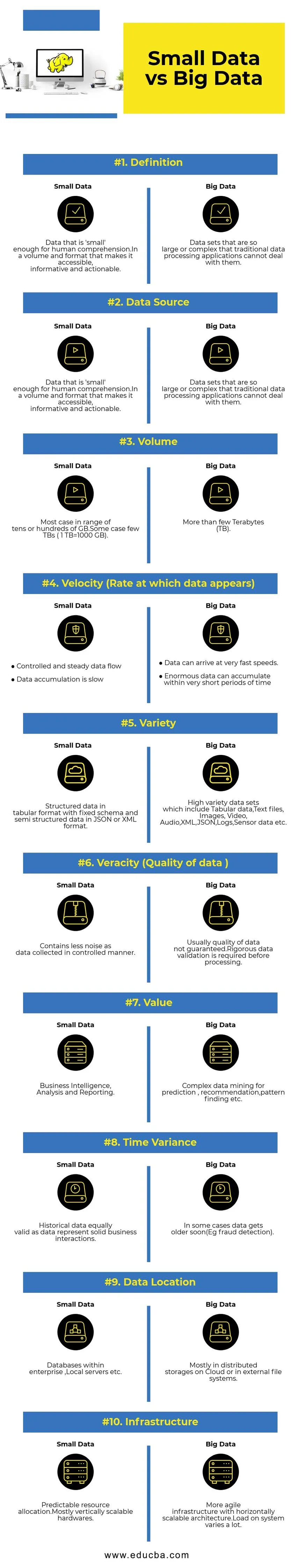

Comparación cara a cara entre datos pequeños y datos grandes (Infografía)

A continuación se muestran las 10 principales diferencias entre Small Data y Big Data

Diferencias clave entre Small Data y Big Data

- Recopilación de datos : por lo general, los datos pequeños son parte de los sistemas OLTP y se recopilan de manera más controlada que luego se insertan en la capa de caché o la base de datos. Las bases de datos tendrán réplicas leídas para admitir consultas analíticas inmediatas si es necesario. La canalización de recopilación de Big Data tendrá colas como AWS Kinesis o Google Pub / Sub para equilibrar los datos de alta velocidad. Downstream tendrá canales de transmisión para análisis en tiempo real y trabajos por lotes para el procesamiento de datos en frío.

- Procesamiento de datos : como la mayoría de los datos pequeños generados a través del sistema de transacciones, la analítica se orientará por lotes la mayor parte del tiempo. En algunos casos raros, las consultas analíticas se ejecutan directamente sobre los sistemas de transacción. Los entornos de Big Data tendrán canalizaciones de procesamiento por lotes y de flujo. Se utiliza una transmisión para análisis en tiempo real, como la detección de fraude con tarjeta de crédito o la predicción del precio de las acciones. Procesamiento por lotes utilizado para implementar lógica empresarial compleja con datos y algoritmos avanzados.

- Escalabilidad : los sistemas de datos pequeños suelen escalar verticalmente. El escalado vertical aumenta la capacidad del sistema al agregar más recursos a la misma máquina. El escalado vertical es costoso pero menos complejo de administrar. Los sistemas de Big Data dependen principalmente de una arquitectura escalable horizontalmente que brinda más agilidad a un menor costo. Las máquinas virtuales preventivas disponibles en la nube hacen que los sistemas escalables horizontalmente sean aún más asequibles.

- Modelado de datos : los datos pequeños generados a partir de los sistemas de transacción estarán en forma normalizada. Las canalizaciones de datos ETL (Extract Transform Load) los convierten en un esquema de estrella o copo de nieve en un almacén de datos. Aquí el esquema siempre se aplica al escribir datos, lo cual es relativamente fácil ya que los datos están más estructurados. Como se mencionó anteriormente, los datos tabulares son solo una fracción de Big Data. Aquí los datos se replican mucho más por varias razones, como la transferencia de fallas o debido a alguna limitación del motor de la base de datos subyacente (por ejemplo, algunas bases de datos solo admiten un índice secundario por conjunto de datos). Un esquema no se aplica al escribir. En cambio, se valida un esquema mientras se leen los datos.

- Acoplamiento de almacenamiento y computación: en las bases de datos tradicionales que manejan principalmente datos pequeños, el almacenamiento y la computación están estrechamente acoplados. La inserción y recuperación de datos hacia y desde la base de datos solo es posible a través de la interfaz dada. Los datos no se pueden colocar directamente en el sistema de archivos de la base de datos, o los datos existentes no se pueden consultar con otros motores de base de datos. En realidad, esta arquitectura ayuda enormemente a garantizar la integridad de los datos. Los sistemas Big Data tienen un acoplamiento muy flexible entre el almacenamiento y el cómputo. Por lo general, los datos se almacenan en un sistema de almacenamiento de datos distribuido como HDFS, AWS S3 o Google GCS y un motor de cómputo para consultar datos o hacer ETL seleccionados en un momento posterior. Por ejemplo, las consultas interactivas pueden ejecutarse usando Presto (Link) y ETL usando Apache Hive en los mismos datos.

- Ciencia de datos: los algoritmos de aprendizaje automático requieren datos de entrada en un formato bien estructurado y codificado adecuadamente, y la mayoría de las veces los datos de entrada serán de sistemas transaccionales como un almacén de datos y almacenamiento de Big Data como un lago de datos. Los algoritmos de aprendizaje automático que se ejecutan únicamente en Small Data serán fáciles, ya que la etapa de preparación de datos es estrecha. Preparar y enriquecer datos en el entorno de Big Data lleva mucho más tiempo. Big Data ofrece muchas opciones para la experimentación de la ciencia de datos debido al alto volumen y la variedad de datos.

- Seguridad de datos : prácticas de seguridad para Small Data que residen en el almacén de datos de la empresa o en los sistemas de transacción proporcionados por los proveedores de bases de datos correspondientes que pueden incluir privilegios de usuario, cifrado de datos, hash, etc. Asegurar los sistemas Big Data es mucho más complicado y desafiante. Las mejores prácticas de seguridad incluyen cifrar datos en reposo y tránsito, aislar la red de clúster, reglas de control de acceso sólidas, etc.

Tabla de comparación de datos pequeños versus datos grandes

| Bases de comparación | Datos pequeños | Big Data |

| Definición | Datos que son 'lo suficientemente pequeños' para la comprensión humana. En un volumen y formato que los hace accesibles, informativos y procesables. | Conjuntos de datos que son tan grandes o complejos que las aplicaciones tradicionales de procesamiento de datos no pueden manejarlos |

| Fuente de datos | ● Datos de sistemas empresariales tradicionales como ○ Planificación de recursos empresariales ○ Gestión de relaciones con clientes (CRM) ● Datos financieros como datos del libro mayor ● Datos de transacciones de pago del sitio web | ● Comprar datos desde el punto de venta ● Datos de Clickstream de sitios web ● Datos de transmisión GPS: datos de movilidad enviados a un servidor ● Redes sociales: facebook, twitter |

| Volumen | La mayoría de los casos en un rango de decenas o cientos de GB. Algunos casos pocos TB (1 TB = 1000 GB) | Más de unos pocos terabytes (TB) |

| Velocidad (velocidad a la que aparecen los datos) | ● Flujo de datos controlado y constante ● La acumulación de datos es lenta. | ● Los datos pueden llegar a velocidades muy rápidas. ● Se pueden acumular datos enormes en muy poco tiempo. |

| Variedad | Datos estructurados en formato tabular con esquema fijo y datos semiestructurados en formato JSON o XML | Conjuntos de datos de gran variedad que incluyen datos tabulares, archivos de texto, imágenes, video, audio, XML, JSON, registros, datos de sensores, etc. |

| Veracidad (calidad de los datos) | Contiene menos ruido a medida que los datos se recopilan de manera controlada. | Por lo general, la calidad de los datos no está garantizada. Se requiere una validación de datos rigurosa antes del procesamiento. |

| Valor | Inteligencia empresarial, análisis e informes | Minería de datos compleja para predicción, recomendación, búsqueda de patrones, etc. |

| Varianza de tiempo | Los datos históricos son igualmente válidos ya que los datos representan interacciones comerciales sólidas | En algunos casos, los datos envejecen pronto (por ejemplo, detección de fraude). |

| Ubicación de datos | Bases de datos dentro de una empresa, servidores locales, etc. | Principalmente en almacenes distribuidos en la nube o en sistemas de archivos externos. |

| Infraestructura | Asignación de recursos predecible. Hardware mayormente escalable verticalmente | Infraestructura más ágil con una arquitectura escalable horizontalmente. La carga en el sistema varía mucho. |

Conclusión: Small Data vs Big Data

El objetivo final del análisis de datos es obtener información oportuna para respaldar la toma de decisiones. Categorizar los datos en pequeños y grandes ayuda para abordar los desafíos en el análisis de datos de cada mundo por separado con las herramientas adecuadas. La línea entre dos categorías varía con los sistemas de procesamiento de datos avanzados emergentes, lo que hace que incluso las consultas de big data sean mucho más rápidas y menos complejas.

Artículos recomendados:

Esta ha sido una guía para Small Data vs Big Data, su significado, comparación directa, diferencias clave, tabla de comparación y conclusión. Este artículo incluye todas las diferencias importantes entre Small Data y Big Data. También puede consultar los siguientes artículos para obtener más información:

- Big Data vs Data Science: ¿en qué se diferencian?

- Big Data: importante de la confluencia de la tecnología y el análisis empresarial

- Las 5 principales tendencias de Big Data que las empresas tendrán que dominar

- 16 consejos interesantes para convertir Big Data en Big Success