¿Qué es la PNL en Python?

La inteligencia artificial ha evolucionado enormemente en la última década, y también lo es uno de sus subcampos: el procesamiento del lenguaje natural. El avance en la inteligencia artificial es el resultado de la capacidad computacional masiva de los sistemas modernos y los grandes volúmenes de datos no estructurados que se generan a partir de una gran cantidad de fuentes. El procesamiento del lenguaje natural o PNL es el estudio de la inteligencia artificial que permite a las computadoras procesar datos textuales no estructurados sin procesar y extraer información oculta de ellos.

Definición

A diferencia de los humanos, las computadoras no son lo suficientemente inteligentes como para procesar datos no estructurados. Los seres humanos podrían obtener significados de dichos datos, mientras que las computadoras solo podrían hacerlo con los datos estructurados almacenados en las bases de datos. Para encontrar patrones y obtener significado de los datos naturales, las computadoras usan las herramientas y técnicas involucradas en la PNL para procesar dichos datos.

¿Cómo funciona la PNL en Python?

Es muy complejo leer y entender inglés. La siguiente oración es uno de esos ejemplos en los que es realmente difícil para la computadora comprender el pensamiento real detrás de la oración.

En Machine Learning, se construye una tubería para cada problema en el que cada parte de un problema se resuelve por separado utilizando ML. El resultado final sería la combinación de varios modelos de aprendizaje automático encadenados. El procesamiento del lenguaje natural funciona de manera similar a esto, donde la oración en inglés se divide en fragmentos.

Hay varios hechos presentes en este párrafo. Las cosas habrían sido fáciles si las computadoras mismas pudieran entender lo que es Londres, pero para hacerlo, las computadoras deben estar capacitadas con conceptos básicos de lenguaje escrito.

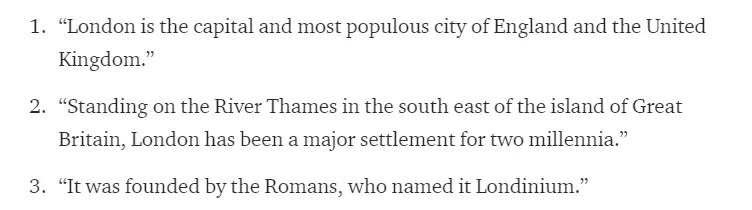

1. Segmentación de la oración : el corpus se divide en varias oraciones como se muestra a continuación.

Esto facilitaría nuestra vida, ya que es mejor procesar una sola oración que un párrafo en su conjunto. La división se puede hacer en base a signos de puntuación, o varias otras técnicas complicadas que también funcionan en datos sin limpiar.

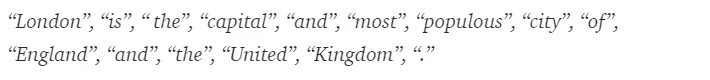

2. Tokenización de palabras : una oración se puede dividir en el token de las palabras como se muestra a continuación.

Después de la tokenización, la oración anterior se divide en -

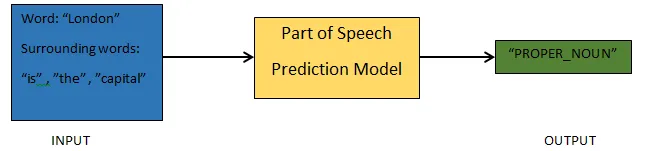

3. Predicción de partes del habla : este proceso consiste en generar las partes del habla para cada token. Esto nos permitiría comprender el significado de la oración y el tema del que se habla en la oración.

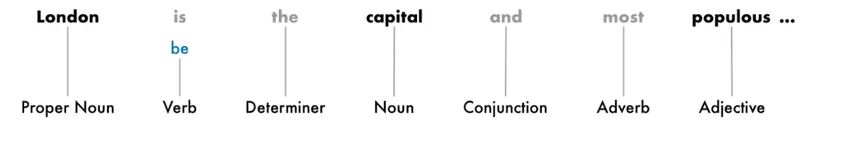

4. Lematización : una palabra en una oración puede aparecer en diferentes formas. La lematización rastrea una palabra hasta su raíz, es decir, el lema de cada palabra.

5. Detener la identificación de palabras : hay muchas palabras de relleno como 'la', 'a' en una oración. Estas palabras actúan como ruido en un texto cuyo significado estamos tratando de extraer. Por lo tanto, es necesario filtrar esas palabras vacías para construir un mejor modelo.

Según la aplicación, las palabras de detención pueden variar. Sin embargo, hay una lista predefinida de trabajos de parada a los que uno podría referirse.

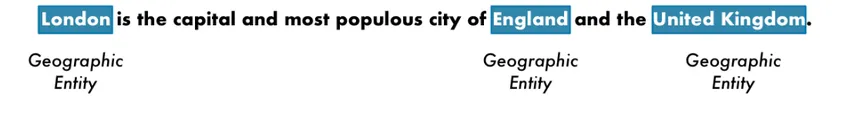

6. Reconocimiento de entidad nombrada : NER es el proceso de encontrar entidades como nombre, lugar, persona, organización, etc., de una oración.

Aquí se usa el contexto de la aparición de una palabra en una oración. Para obtener datos estructurados de un texto, los sistemas NER tienen muchos usos.

Ejemplo de PNL en Python

La mayoría de las empresas ahora están dispuestas a procesar datos no estructurados para el crecimiento de sus negocios. La PNL tiene una amplia gama de usos, y uno de los casos de uso más comunes es la Clasificación de texto.

La clasificación de texto en diferentes categorías automáticamente se conoce como clasificación de texto. La detección de spam o jamón en un correo electrónico, la categorización de artículos de noticias, son algunos de los ejemplos comunes de clasificación de texto. Los datos utilizados para este propósito deben etiquetarse.

Los pocos pasos en una tubería de clasificación de texto que deben seguirse son:

- La carga y el preprocesamiento de los datos es el primer paso, y luego se dividiría en tren y conjunto de validación.

- El paso de Ingeniería de características implica extraer las características útiles o crear características significativas adicionales que ayudarían a desarrollar un mejor modelo predictivo.

- Para construir el modelo, el conjunto de datos etiquetado se usa para entrenar el modelo.

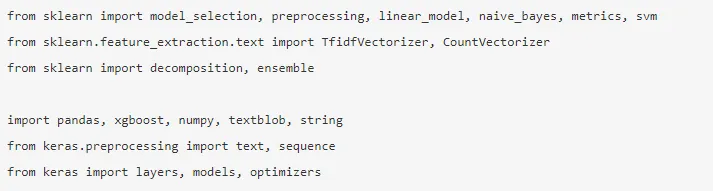

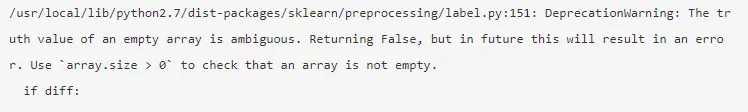

Pandas, Scikit-learn, XGBoost, TextBlog, Keras son algunas de las bibliotecas necesarias que necesitamos instalar. Luego importaríamos las bibliotecas para la preparación de conjuntos de datos, ingeniería de características, etc.

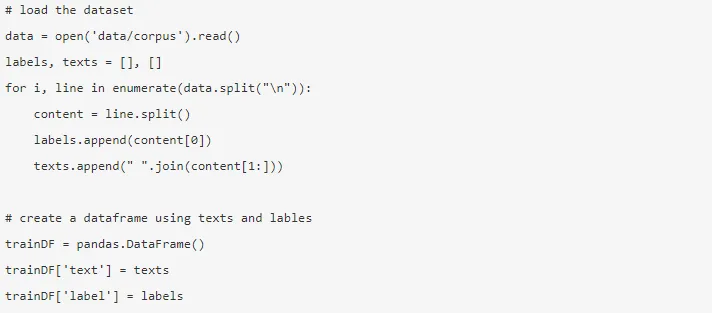

Los datos son enormes, con casi 3, 6 millones de reseñas que se pueden descargar desde aquí. Se utiliza una fracción de los datos. Se descarga y se lee en un marco de datos de Pandas.

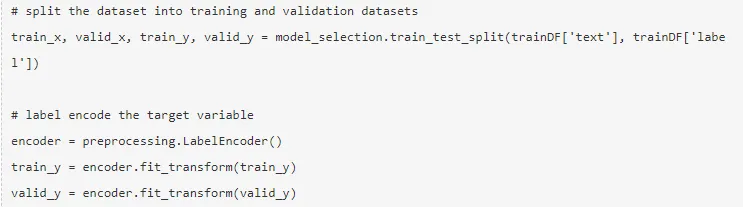

La variable objetivo se codifica y los datos se dividen en trenes y conjuntos de prueba.

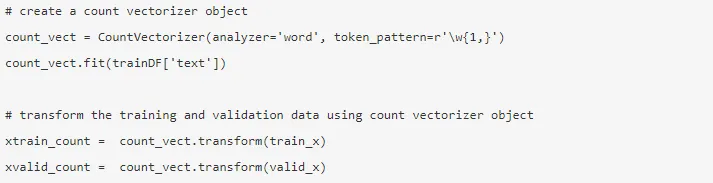

La ingeniería de características se realiza utilizando los siguientes métodos diferentes.

1. Vectores de conteo - La representación de un documento, un término y su frecuencia a partir de un corpus se logra mediante los vectores de conteo.

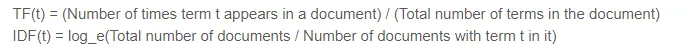

2. Vectores TF-IDF : en un documento, la importancia relativa de un término está representada por la frecuencia de término (TF) y la puntuación de frecuencia de documento inverso (IDF). El TF-IDF podría calcularse mediante:

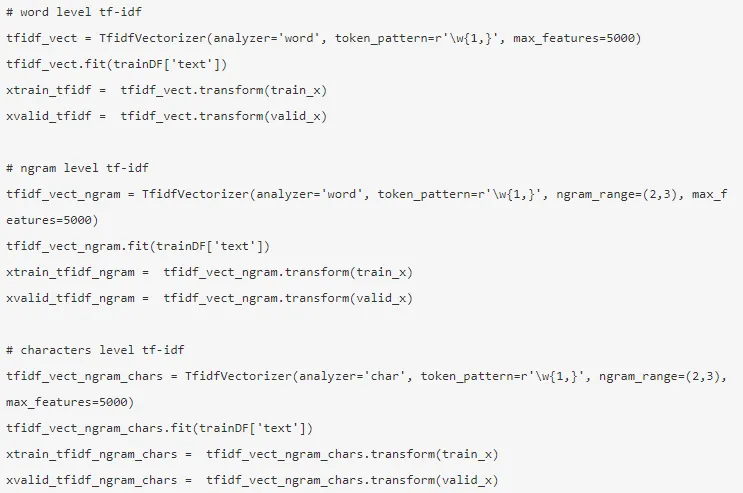

Los vectores TF-IDF podrían generarse por nivel de Word, que presenta la puntuación de cada término, y el nivel de N-grama, que es la combinación de n-términos.

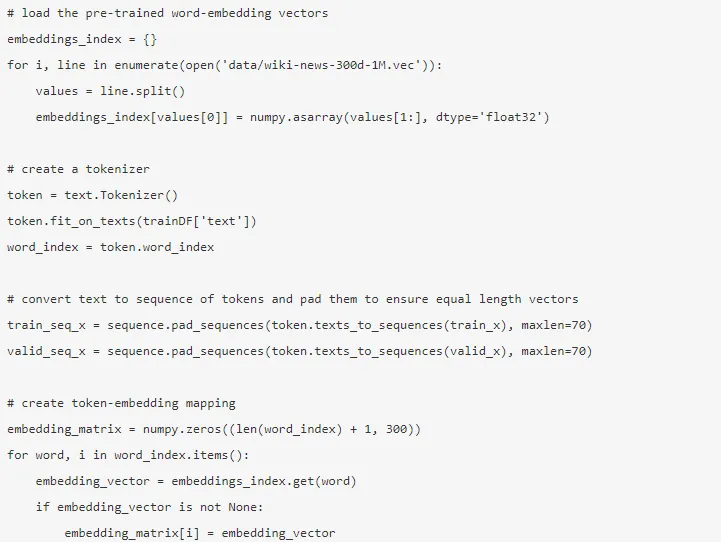

3. Incrustación de palabras : la representación de documentos y palabras en forma de un vector denso se conoce como incrustación de palabras. Hay incrustaciones pre-entrenadas como Glove, Word2Vec que podrían usarse o también podrían entrenarse.

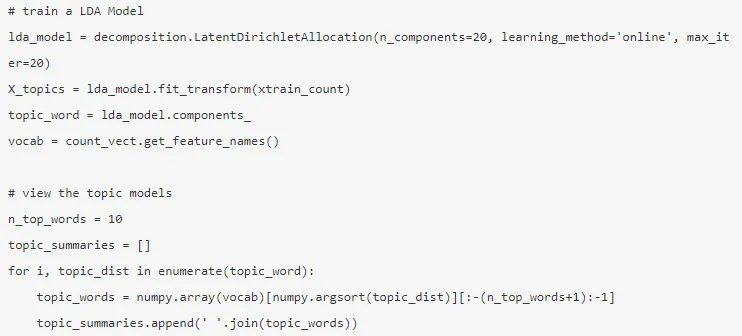

4. Modelos de temas : es el grupo de palabras de un documento que contiene la mayor cantidad de información. La asignación de Dirichlet latente se utiliza aquí para modelar temas.

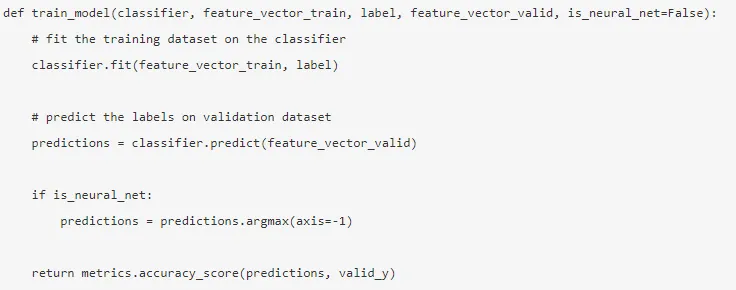

El modo se construye después de que se realiza la ingeniería de características y se extraen las características relevantes.

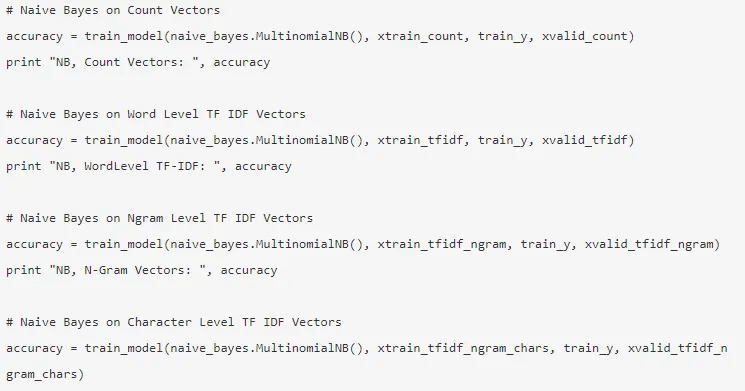

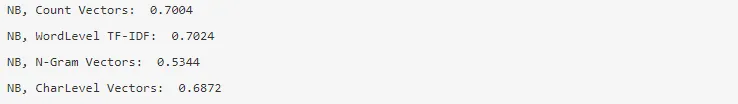

5. Naïve Bayes : se basa en el teorema de Bayes, y el algoritmo cree que no hay relación entre las características de un conjunto de datos.

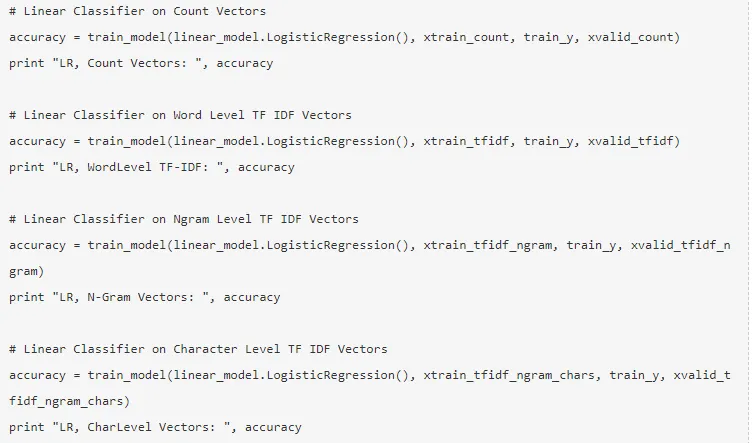

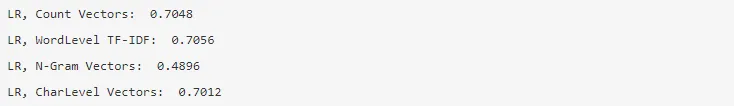

6. Regresión logística : mide la relación lineal entre las características y la variable objetivo se mide en función de una función sigmoidea que estima las probabilidades.

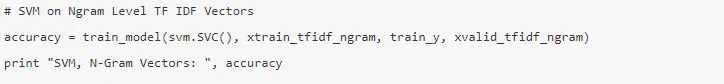

7. Máquina de vectores de soporte : un hiperplano separa dos clases en un SVM.

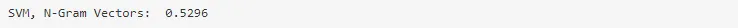

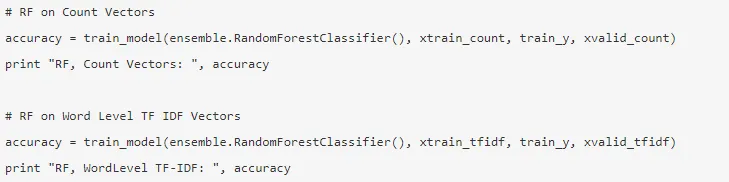

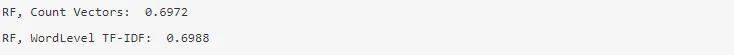

8. Modelo de bosque aleatorio : un modelo de conjunto donde reduce la varianza y agrupa múltiples árboles de decisión.

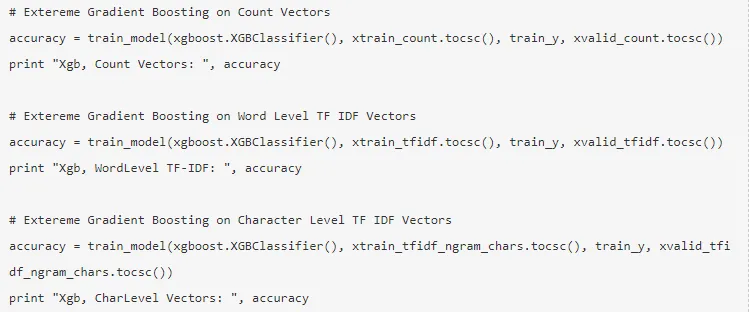

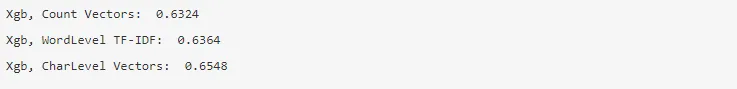

9. XG Boost : el sesgo se reduce y los alumnos débiles se convierten en fuertes.

¿Cómo te ayudaría la PNL en tu carrera?

El procesamiento del lenguaje natural es un campo en auge en el mercado y casi todas las organizaciones necesitan un ingeniero de PNL para ayudarles a procesar los datos sin procesar. Por lo tanto, es imprescindible dominar las habilidades necesarias, ya que no habría escasez de puestos de trabajo en el mercado.

Conclusión: PNL en Python

En este artículo, comenzamos con una introducción a NLP en Python y luego implementamos un caso de uso en Python para mostrar cómo trabajar con NLP en Python.

Artículos recomendados

Esta ha sido una guía para la PNL en Python. Aquí discutimos el Ejemplo, Casos de uso y cómo trabajar con PNL en Python. También puede consultar nuestros otros artículos sugeridos para obtener más información:

- Usos de Python

- ¿Qué es la WBS?

- Python vs Scala

- ¿Qué es el cuadro?