Introducción al árbol de decisiones en el aprendizaje automático

El árbol de decisiones en Machine Learning tiene un amplio campo en el mundo moderno. Hay muchos algoritmos en ML que se utilizan en nuestro día a día. Uno de los algoritmos importantes es el Árbol de decisión que se usa para la clasificación y también una solución para los problemas de regresión. Como es un modelo predictivo, el Análisis de árbol de decisión se realiza mediante un enfoque algorítmico en el que un conjunto de datos se divide en subconjuntos según las condiciones. El nombre en sí dice que es un modelo similar a un árbol en forma de declaraciones if-then-else. Cuanto más profundo es el árbol y más son los nodos, mejor es el modelo.

Tipos de árbol de decisión en el aprendizaje automático

El árbol de decisión es un gráfico similar a un árbol donde la clasificación comienza desde el nodo raíz hasta el nodo hoja hasta que se alcanza el objetivo. Es el más popular para la decisión y clasificación basada en algoritmos supervisados. Se construye mediante particiones recursivas donde cada nodo actúa como un caso de prueba para algunos atributos y cada borde, derivado del nodo, es una posible respuesta en el caso de prueba. Los nodos raíz y hoja son dos entidades del algoritmo.

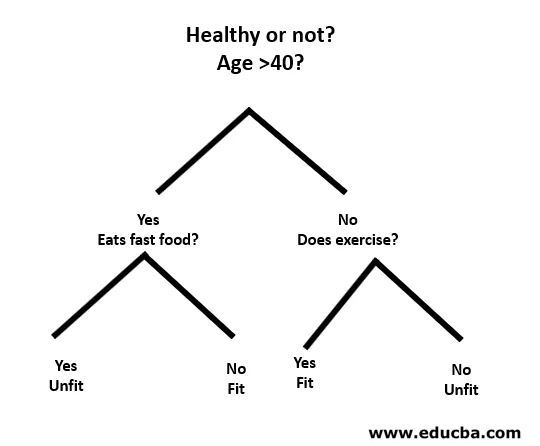

Comprendamos con la ayuda de un pequeño ejemplo de la siguiente manera:

Aquí, el nodo raíz es si tienes menos de 40 años o no. Si es así, ¿comes comida rápida? En caso afirmativo, entonces no está en forma o, de lo contrario, está en forma. Y si tienes más de 40 años, ¿haces ejercicio? Si es así, entonces estás en forma o, de lo contrario, no estás en forma. Esto era básicamente una clasificación binaria.

Hay dos tipos de árboles de decisión:

- Árboles de clasificación: el ejemplo anterior es un árbol de clasificación basado en categorías.

- Árboles de regresión : en este tipo de algoritmo, la decisión o el resultado es continuo. Tiene una salida numérica única con más entradas o predictores.

En el árbol de decisiones, el desafío típico es identificar el atributo en cada nodo. El proceso se llama selección de atributo y tiene algunas medidas para usar para identificar el atributo.

a. Ganancia de información (IG)

La ganancia de información mide cuánta información proporciona una característica individual sobre la clase. Actúa como la clave principal para construir un árbol de decisión. Un atributo con la ganancia de información más alta se divide primero. Por lo tanto, el Árbol de decisiones siempre maximiza la ganancia de información. Cuando usamos un nodo para dividir las instancias en subconjuntos más pequeños, la entropía cambia.

Entropía: es la medida de incertidumbre o impureza en una variable aleatoria. La entropía decide cómo un árbol de decisión divide los datos en subconjuntos.

La ecuación para ganancia de información y entropía es la siguiente:

Información obtenida = entropía (primaria) - (promedio ponderado * entropía (secundaria))

Entropía: ∑p (X) log p (X)

P (X) aquí es la fracción de ejemplos en una clase dada.

si. Índice de Gini

El índice de Gini es una métrica que decide con qué frecuencia se identificará incorrectamente un elemento elegido al azar. Establece claramente que el atributo con un índice de Gini bajo tiene la primera preferencia.

Índice de Gini: 1-∑ p (X) 2

Creación dividida

- Para crear una división, primero, necesitamos calcular la puntuación de Gini.

- Los datos se dividen utilizando una lista de filas que tienen un índice de un atributo y un valor dividido de ese atributo. Después de encontrar el conjunto de datos derecho e izquierdo, podemos obtener el valor dividido por el puntaje de Gini de la primera parte. Ahora, el valor dividido será el decisor donde residirá el atributo.

- La siguiente parte es evaluar todas las divisiones. El mejor valor posible se calcula evaluando el costo de la división. La mejor división se usa como un nodo del Árbol de decisión.

Construir un árbol: árbol de decisión en el aprendizaje automático

Hay dos pasos para construir un árbol de decisión.

1. Creación del nodo terminal

Al crear el nodo terminal, lo más importante es tener en cuenta si necesitamos dejar de cultivar árboles o continuar. Las siguientes formas se pueden utilizar para esto:

- Profundidad máxima del árbol: cuando el árbol alcanza el número máximo de nodos, la ejecución se detiene allí.

- Registros mínimos de nodo: se puede definir como un mínimo de patrones que requiere un nodo. Entonces podemos dejar de agregar nodos terminales de inmediato y obtenemos esos registros mínimos de nodo.

2. División recursiva

Una vez que se crea el nodo, podemos crear un nodo hijo de forma recursiva dividiendo el conjunto de datos y llamando a la misma función varias veces.

Predicción

Después de construir un árbol, la predicción se realiza mediante una función recursiva. El mismo proceso de predicción se sigue nuevamente con los nodos secundarios izquierdo o derecho, y así sucesivamente.

Ventajas y desventajas del árbol de decisión

A continuación se presentan algunas ventajas y desventajas:

Ventajas

El árbol de decisión tiene algunas ventajas en Machine Learning de la siguiente manera:

- Completo: toma en consideración cada posible resultado de una decisión y rastrea cada nodo hasta la conclusión correspondiente.

- Específico: los árboles de decisión asignan un valor específico a cada problema, decisión y resultado (s). Reduce la incertidumbre y la ambigüedad y también aumenta la claridad.

- Simplicidad: Decision Tree es uno de los algoritmos más fáciles y confiables, ya que no tiene fórmulas complejas ni estructuras de datos. Solo se requieren estadísticas y matemáticas simples para el cálculo.

- Versátil: los árboles de decisión se pueden construir manualmente usando matemáticas y también se pueden usar con otros programas de computadora.

Desventajas

El árbol de decisión tiene algunas desventajas en Machine Learning de la siguiente manera:

- Los árboles de decisión son menos apropiados para la estimación y las tareas financieras donde necesitamos un valor apropiado.

- Es un algoritmo de clasificación propenso a errores en comparación con otros algoritmos computacionales.

- Es computacionalmente costoso. En cada nodo, la división candidata debe clasificarse antes de determinar la mejor. Existen otras alternativas que muchas entidades comerciales siguen para las tareas financieras, ya que el Árbol de decisión es demasiado costoso para la evaluación.

- Mientras trabaja con variables continuas, Decision Tree no es la mejor solución, ya que tiende a perder información al clasificar las variables.

- A veces es inestable ya que pequeñas variaciones en el conjunto de datos pueden conducir a la formación de un nuevo árbol.

Conclusión: Árbol de decisión en el aprendizaje automático

Como uno de los algoritmos más importantes y supervisados, Decision Tree desempeña un papel vital en el análisis de decisiones en la vida real. Como modelo predictivo, se utiliza en muchas áreas por su enfoque dividido que ayuda a identificar soluciones basadas en diferentes condiciones mediante el método de clasificación o regresión.

Artículos recomendados

Esta es una guía para el Árbol de decisiones en el aprendizaje automático. Aquí discutimos la introducción, Tipos de árbol de decisión en Machine Learning, Creación dividida y Construcción de un árbol. También puede consultar nuestros otros artículos sugeridos para obtener más información:

- Tipos de datos de Python

- Conjuntos de datos de Tableau

- Cassandra Data Modeling

- Prueba de tabla de decisiones

- Las 8 etapas principales del ciclo de vida del aprendizaje automático