Diferencia entre Hadoop y SQL

La enorme cantidad de datos generados cada segundo a través de las redes sociales como Facebook, Twitter e Instagram ha allanado el camino para el desarrollo de Hadoop / Big Data Ecosystem. El término "3V" que se refiere a Volumen, Velocidad y Veracidad define la importancia de Hadoop para manejar la transmisión de datos. Hoy en día, los datos se generan a partir de múltiples fuentes que deben integrarse para diversos fines, como informes, análisis de datos e investigación, y para el almacenamiento centralizado de datos. Cuando lo hacemos, surgen numerosos problemas con los enfoques tradicionales como el espacio, el acceso, la integridad, la estructura y el ancho de banda. Para manejar todos estos problemas, Hadoop proporciona un marco que permite procesar los datos con gran tamaño, proporcionar un acceso fácil, alta disponibilidad y cargar datos dinámicamente. Tiene un marco de Sistema de archivos distribuido (HDFS) para el almacenamiento de datos y un procesador de consultas incorporado llamado "Map Reduce" para el análisis y procesamiento de datos almacenados en HDFS.

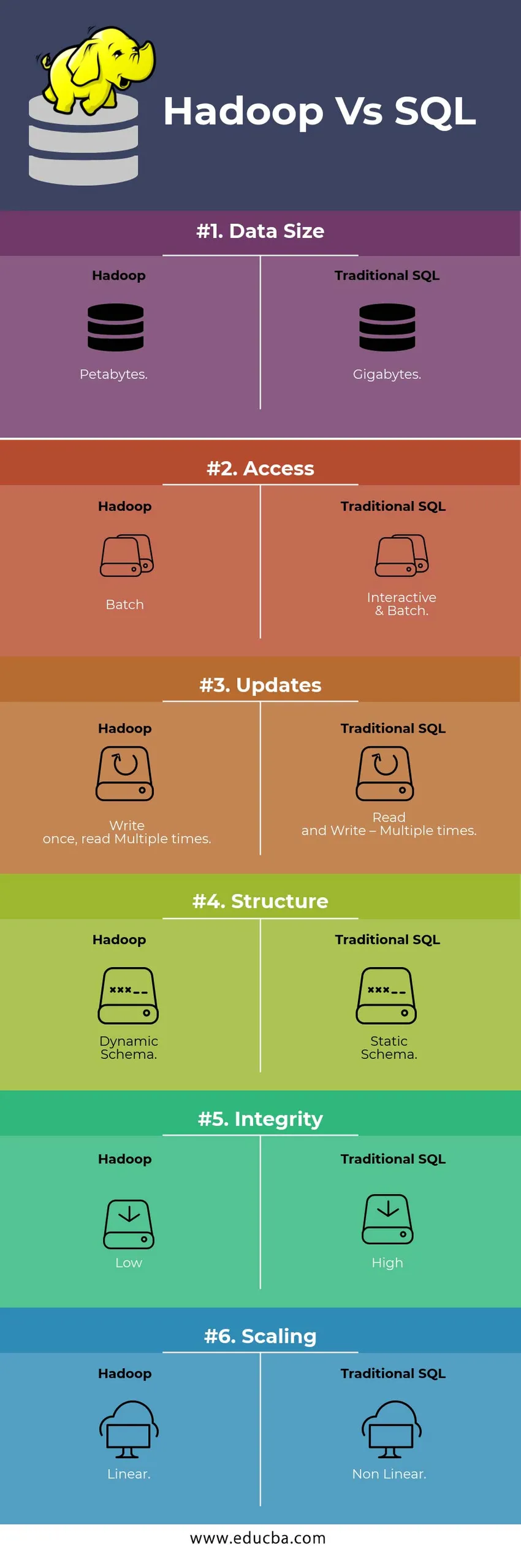

Comparación HEAD TO HEAD entre Hadoop Vs SQL

A continuación se muestran las 6 principales diferencias entre Hadoop Vs SQL

Diferencias clave entre Hadoop Vs SQL

A continuación se muestra la diferencia entre Hadoop y SQL:

- Esquema de ESCRIBIR V LEÍDO

Generalmente en una base de datos tradicional, durante la carga / migración de datos de una base de datos a otra, sigue el esquema en el enfoque de escritura. Esto hace que el proceso de carga de datos se excite / cancele y resulta en el rechazo de registros debido a una diferencia en la estructura de las tablas de origen y destino, mientras que en el sistema Hadoop, todos los datos se almacenan en HDFS y los datos están centralizados.

El marco Hadoop se utiliza principalmente para el proceso de análisis de datos. Por lo tanto, admite las tres categorías de datos, es decir, datos estructurados, semiestructurados y no estructurados, y permite el esquema en el enfoque de lectura.

- Los datos estructurados tienen un formato definido. g .: archivo XML.

- Los datos de semi estructuras son más flexibles; Puede / no tener un esquema. g .: hoja de cálculo

- Los datos no estructurados no tienen una estructura específica o un esquema. Por ejemplo: texto sin formato o imagen.

Hadoop trabaja eficientemente con datos no estructurados ya que tiene la capacidad de interpretar los datos durante el tiempo de procesamiento.

| Acercarse | Ventaja | Desventaja |

| Esquema de escritura | · Estructuras predefinidas

· Lectura más rápida. Por ejemplo: RDBMS tradicional. | Carga lenta de datos

Alta latencia |

| Esquema de lectura | · Estructura dinámica

· Escritura y lectura rápidas. Ej .: Hadoop | Carga rápida de datos

Baja latencia |

Tabla : Esquema en ESCRIBIR VS Esquema en LEER.

- ESCALABILIDAD Y COSTO

Hadoop Framework está diseñado para procesar un gran volumen de datos. Cada vez que aumenta el tamaño de los datos, se pueden agregar una cantidad de recursos adicionales como el nodo de datos al clúster con mucha facilidad que el enfoque tradicional de la asignación de memoria estática. Time and Budget es relativamente menos para implementarlos y también Hadoop proporciona Localidad de datos donde los datos están disponibles en el nodo que ejecutó el trabajo.

- TOLERANCIA A FALLOS

En el RDBMS tradicional, cuando los datos se pierden debido a la corrupción o cualquier problema de red, se necesita más tiempo, costo y recursos para recuperar los datos perdidos. Pero, Hadoop tiene un mecanismo donde los datos tienen un factor mínimo de tres niveles de replicación para los datos que se almacenan en HDFS. Si uno de los nodos de datos que contiene datos falla, los datos se pueden extraer fácilmente de otros nodos de datos con alta disponibilidad de datos. Por lo tanto, los datos están fácilmente disponibles para el usuario, independientemente de cualquier falla.

- PROGRAMACIÓN FUNCIONAL

Hadoop admite la escritura de programación funcional en lenguajes como Java, Scala y Python. Para cualquier aplicación que requiera cualquier funcionalidad adicional, se puede implementar registrando UDF - Funciones definidas por el usuario en el HDFS. En RDBMS, no hay posibilidad de escribir UDF y esto aumenta la complejidad de escribir SQL. Además, todos los ecosistemas de Hadoop pueden acceder a los datos almacenados en HDFS, como Hive, Pig, Sqoop y HBase. Por lo tanto, si el UDF está escrito, puede ser utilizado por cualquiera de las aplicaciones mencionadas anteriormente. Aumenta el rendimiento y la capacidad de soporte del sistema.

- MEJORAMIENTO

Hadoop almacena datos en HDFS y Process a través de Map Reduce con enormes técnicas de optimización. Las técnicas más populares utilizadas para manejar datos son el particionamiento y el almacenamiento de los datos almacenados. La partición es un enfoque para almacenar los datos en HDFS dividiendo los datos en función de la columna mencionada para la partición. Cuando los datos se inyectan o cargan en HDFS, identifica la columna de partición y empuja los datos al directorio de la partición correspondiente. Por lo tanto, la consulta obtiene el conjunto de resultados al obtener directamente los datos del directorio particionado. Esto reduce el escaneo completo de la tabla, mejora el tiempo de respuesta y evita la latencia.

Otro enfoque se llama Bucketing de los datos. Esto permite al analista distribuir fácilmente los datos entre los nodos de datos. Todos los nodos tendrán un número igual de datos distribuidos. La columna de bucketing se selecciona de tal manera que tenga el menor número de cardinalidad.

Estos enfoques no están disponibles en el método tradicional de SQL.

- TIPO DE DATOS

En un enfoque tradicional, los tipos de datos admitidos son muy limitados. Solo admite datos estructurados. Por lo tanto, limpiar y formatear el esquema de datos en sí llevará más tiempo. Pero, Hadoop admite tipos de datos complejos como Array, Struct y Map. Esto fomenta el uso de los diferentes tipos de un conjunto de datos para la carga de datos. Por ejemplo: los datos XML se pueden cargar definiendo los datos con elementos XML que contienen un tipo de datos complejo.

- COMPRESIÓN DE DATOS

Hay muy pocas técnicas de compresión incorporadas disponibles para el sistema de base de datos tradicional. Pero para el framework Hadoop, hay muchas técnicas de compresión como gzib, bzip2, LZO y snappy. El modo de compresión predeterminado es LZ4. Incluso las tablas se pueden comprimir utilizando las técnicas de compresión como Parquet, ORC. Las técnicas de compresión ayudan a que las tablas ocupen muy poco espacio, aumentan el rendimiento y una ejecución de consulta más rápida.

Tabla de comparación de SQL de Hadoop Vs

| Caracteristicas | SQL tradicional | Hadoop |

| Tamaño de datos | Gigabytes | Petabytes |

| Acceso | Interactivo y por lotes | Lote |

| Actualizaciones | Leer y escribir: varias veces | Escribe una vez, lee varias veces |

| Estructura | Esquema estático | Esquema dinámico |

| Integridad | Alto | Bajo |

| Escalada | No lineal | Lineal |

Tabla : Comparación entre Hadoop tradicional y SQL Framework.

Conclusión - Hadoop Vs SQL

En general, Hadoop se adelanta al SQL tradicional en términos de costo, tiempo, rendimiento, confiabilidad, compatibilidad y disponibilidad de datos para el gran grupo de usuarios. Con el fin de manejar eficientemente la enorme cantidad de datos generados todos los días, el marco Hadoop ayuda a capturar, almacenar, procesar, filtrar y finalmente almacenar en un lugar centralizado.

Artículo recomendado

- Hadoop vs Hive - Descubre las mejores diferencias

- Aprenda las 10 diferencias útiles entre Hadoop y Redshift

- HADOOP vs RDBMS | Conozca las 12 diferencias útiles

- Apache Hadoop vs Apache Spark | ¡Las 10 mejores comparaciones que debes conocer!

- Hadoop vs Spark: características