Diferencia entre Apache Hive y Apache Spark SQL

Con la gran cantidad de aumento en las tecnologías de big data hoy en día, se está volviendo muy importante utilizar la herramienta adecuada para cada proceso. El proceso puede ser cualquier cosa como ingestión de datos, procesamiento de datos, recuperación de datos, almacenamiento de datos, etc. En esta publicación, vamos a leer sobre dos herramientas de recuperación de datos, Apache Hive y Apache Spark SQL. Hive, por un lado, es conocido por su eficiente procesamiento de consultas al hacer uso de HQL (Hive Query Language) similar a SQL y se utiliza para los datos almacenados en el Sistema de archivos distribuidos de Hadoop, mientras que Spark SQL utiliza lenguaje de consulta estructurado y se asegura de que todo Se ocupan de las operaciones de lectura y escritura en línea. Se sabe que Hive es el componente del ecosistema de Big Data, donde se necesitan mapeadores y reductores heredados para procesar datos de HDFS, mientras que Spark SQL es el componente de Apache Spark API que ha hecho que el procesamiento en el ecosistema de Big Data sea mucho más fácil y real. -hora. Una idea errónea importante que la mayoría de los profesionales tienen hoy en día es que la colmena solo se puede usar con tecnología y herramientas heredadas de big data como PIG, HDFS, Sqoop, Oozie. Esta afirmación no es completamente cierta ya que Hive es compatible no solo con las herramientas heredadas sino también con otros componentes basados en Spark, como Spark Streaming. La idea detrás de usarlos es reducir el esfuerzo y brindar mejores resultados para el negocio. Estudiemos en detalle tanto Apache Hive como Apache Spark SQL.

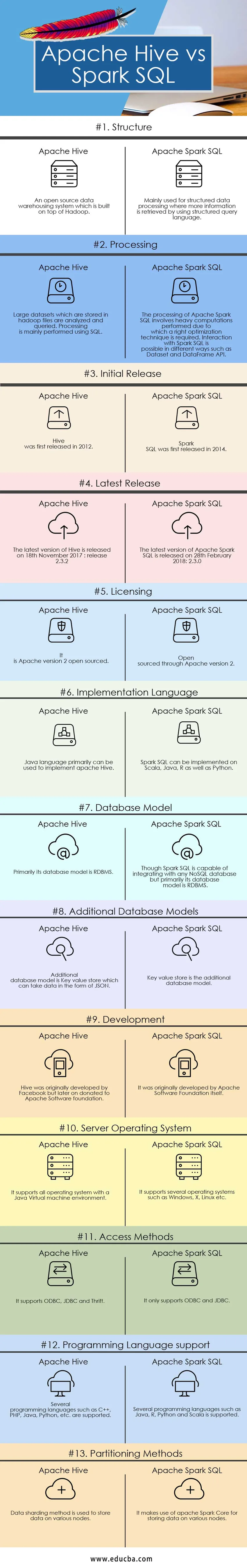

Comparación cabeza a cabeza entre Apache Hive y Apache Spark SQL (Infografía)

A continuación se muestra la comparación de 13 principales entre Apache Hive vs Apache Spark SQL

Diferencias clave entre Apache Hive y Apache Spark SQL

Diferencias clave entre Apache Hive y Apache Spark SQL

Las diferencias entre Apache Hive y Apache Spark SQL se discuten en los puntos mencionados a continuación:

- Se sabe que Hive hace uso de HQL (Hive Query Language), mientras que Spark SQL hace uso de lenguaje de consulta estructurado para procesar y consultar datos

- Hive proporciona flexibilidad de esquema, dividiendo y agrupando las tablas, mientras que Spark SQL realiza consultas SQL solo es posible leer datos de la instalación existente de Hive.

- Hive proporciona derechos de acceso para usuarios, roles y grupos, mientras que Spark SQL no proporciona ninguna facilidad para proporcionar derechos de acceso a un usuario

- Hive proporciona la facilidad de factor de replicación selectiva para el almacenamiento redundante de datos, mientras que spark SQL, por otro lado, no proporciona ningún factor de replicación para almacenar datos

- Como JDBC, ODBC y controladores de ahorro están disponibles en Hive, podemos usarlos para generar resultados, mientras que en el caso de Apache Spark SQL podemos recuperar resultados en forma de Datasets y DataFrame API si Spark SQL se ejecuta con otro lenguaje de programación

- Hay varias limitaciones:

- Las actualizaciones a nivel de fila y las consultas OLTP en tiempo real no son posibles usando Apache Hive, mientras que las actualizaciones a nivel de fila y el procesamiento de transacciones en línea en tiempo real es posible usando Spark SQL.

- Proporciona una alta latencia aceptable para la exploración interactiva de datos, mientras que en Spark SQL la latencia proporcionada es mínima para mejorar el rendimiento.

- Hive, como las declaraciones y consultas SQL, admite el tipo UNION, mientras que Spark SQL no puede admitir el tipo UNION.

Tabla de comparación de Apache Hive vs Apache Spark SQL

| Bases de comparación | Colmena Apache | Apache Spark SQL |

| Estructura | Un sistema de almacenamiento de datos de código abierto que está construido sobre Hadoop | Se utiliza principalmente para el procesamiento de datos estructurados donde se recupera más información mediante el uso de un lenguaje de consulta estructurado. |

| Procesando | Los conjuntos de datos grandes que se almacenan en archivos hadoop se analizan y consultan. El procesamiento se realiza principalmente utilizando SQL. | El procesamiento de Apache Spark SQL implica cálculos pesados realizados debido a los cuales se requiere una técnica de optimización correcta. La interacción con Spark SQL es posible de diferentes maneras, como Dataset y DataFrame API. |

| Versión inicial | Hive se lanzó por primera vez en 2012 | Spark SQL se lanzó por primera vez en 2014 |

| Último lanzamiento | La última versión de Hive se lanzará el 18 de noviembre de 2017: versión 2.3.2 | La última versión de Apache Spark SQL se lanzó el 28 de febrero de 2018: 2.3.0 |

| Licencia | Es Apache versión 2 de código abierto | Fuente abierta a través de Apache versión 2 |

| Lenguaje de implementación | El lenguaje Java se puede utilizar principalmente para implementar Apache Hive | Spark SQL se puede implementar en Scala, Java, R y Python |

| Modelo de base de datos | Principalmente su modelo de base de datos es RDBMS | Aunque Spark SQL es capaz de integrarse con cualquier base de datos NoSQL, pero principalmente su modelo de base de datos es RDBMS |

| Modelos de bases de datos adicionales | El modelo de base de datos adicional es un almacén de valores clave que puede tomar datos en forma de JSON | El almacén de valores clave es el modelo de base de datos adicional |

| Desarrollo | La colmena fue desarrollada originalmente por Facebook pero luego fue donada a la fundación Apache Software | Fue desarrollado originalmente por la propia Fundación Apache Software |

| Sistema operativo del servidor | Es compatible con todos los sistemas operativos con un entorno de máquina virtual Java | Es compatible con varios sistemas operativos como Windows, X, Linux, etc. |

| Métodos de acceso | Es compatible con ODBC, JDBC y Thrift | Solo es compatible con ODBC y JDBC |

| Soporte de lenguaje de programación | Se admiten varios lenguajes de programación como C ++, PHP, Java, Python, etc. | Se admiten varios lenguajes de programación como Java, R, Python y Scala. |

| Métodos de particionamiento | El método de fragmentación de datos se utiliza para almacenar datos en varios nodos | Utiliza Apache Spark Core para almacenar datos en varios nodos |

Conclusión: Apache Hive vs Apache Spark SQL

No podemos decir que Apache Spark SQL sea el reemplazo de Hive o viceversa. Es solo que se puede ver que Spark SQL es una API basada en Spark amigable para el desarrollador que tiene como objetivo facilitar la programación. Hive tiene su capacidad especial de cambio frecuente entre motores, por lo que es una herramienta eficiente para consultar grandes conjuntos de datos. El uso y la implementación sobre qué elegir depende de sus objetivos y requisitos. Tanto Apache Hive como Apache Spark SQL son jugadores en su propio campo. Espero que después de leer la publicación, tenga una idea bastante justa sobre las necesidades de su organización. Siga nuestro blog para más publicaciones como estas y nos aseguramos de proporcionar información que fomente su negocio.

Artículo recomendado

Esta ha sido una guía de Apache Hive vs Apache Spark SQL, su significado, comparación directa, diferencias clave, tabla de comparación y conclusión. También puede consultar los siguientes artículos para obtener más información:

- Java vs Nodo JS diferencias

- Apache Pig vs Apache Hive - Top 12 diferencias útiles

- Hadoop vs Hive - Descubre las mejores diferencias

- 7 cosas útiles importantes sobre Apache Spark (Guía)

- Apache Hadoop vs Apache Spark | ¡Las 10 mejores comparaciones que debes conocer!

- Uso de la función ORDER BY en Hive