¿Qué es el cerdo?

Pig es un motor de código abierto, que forma parte de las tecnologías del ecosistema Hadoop. Pig es excelente para trabajar con datos que están más allá de las bases de datos o almacenes de datos tradicionales. Esto puede funcionar bien con datos faltantes, incompletos o inconsistentes, que no tienen esquema. El Pig tiene su propio lenguaje para expresar manipulaciones de datos, que es Pig Latin.

Comprender el cerdo

Pig es una tecnología que le permite escribir scripts de alto nivel, pero extremadamente granulares, que le permite trabajar con datos donde el esquema es desconocido o inconsistente. Pig es una tecnología de código abierto que se ejecuta sobre Hadoop y es parte del ecosistema Hadoop extremadamente vibrante y popular.

Pig funciona bien con datos no estructurados e incompletos, por lo que no es necesario tener el diseño tradicional de reglas y columnas para todo.

Está bien definido y puede funcionar directamente en archivos en HDFS (Hadoop Distributed File System).

El Pig será su tecnología de elección cuando desee obtener datos de la fuente en un almacén de datos.

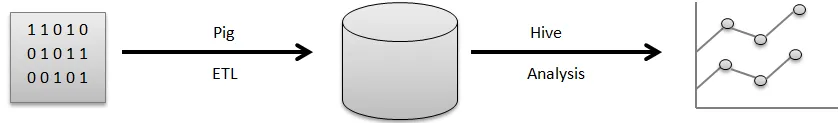

Por ejemplo, una canalización visual de cómo fluyen los datos normalmente antes de que pueda usarlos para generar los buenos gráficos que usa para tomar decisiones comerciales.

Los datos sin procesar provienen de una variedad de fuentes, como sensores, teléfonos móviles, etc. Luego, utilizará Pig para realizar una operación ETL. ETL significa extraer, transformar y cargar, una vez que se realizan estas operaciones, los datos limpiados se almacenan en otra base de datos. Un ejemplo de tal base de datos sería HDFS, que es parte de Hadoop. Hive es un almacén de datos que se ejecutará sobre un sistema de archivos como este. Hive es lo que usaría para el análisis, generar los informes y extraer información.

ETL es un paso muy importante en el procesamiento de datos para limpiar los datos sin procesar y en la forma correcta para almacenarlos en una base de datos. Extracto se refiere a la operación de extraer datos no estructurados e inconsistentes con campos y valores faltantes de la fuente original. Transformar representa la serie de operaciones que aplicaría en los datos para limpiarlos u obtenerlos.

Cálculo previo de información agregada útil, procesamiento de campos para que coincida con un formato determinado, todo esto es parte de la limpieza de datos de los campos de transformación.

Finalmente, Pig realiza la operación de carga donde estos datos limpios se almacenan en una base de datos donde pueden analizarse más a fondo. Un ejemplo de una operación estándar que realiza Pig es limpiar los archivos de registro.

Explicar la arquitectura del cerdo

Hay numerosas partes de cerdo en la arquitectura, prefiera:

- Analizador : el analizador se ocupa de los scripts de Pig y comprueba la sintaxis del script, escribirá la comprobación y varias comprobaciones variadas. Además, su resultado podría ser un DAG (Gráfico Acíclico Dirigido) que generalmente significa las declaraciones de Pig Latin junto con operadores lógicos.

Además, los operadores lógicos con la secuencia de comandos se mostrarán como los nodos, así como los flujos de datos se mostrarán desde los bordes a través de DAG.

- Optimizador: más tarde, el plan lógico (DAG) generalmente se supera hacia el optimizador lógico. Realiza las optimizaciones lógicas adicionales, incluida la proyección y promueve bajas

- Compilador: también, el compilador compila ese plan lógico mejorado en un grupo de trabajos de MapReduce.

- Motor de ejecución: en última instancia, todos los trabajos de MapReduce se publicarán en Hadoop dentro de una secuencia ordenada. Eventualmente, esto genera los resultados requeridos, aunque estos trabajos de MapReduce se llevarán a cabo con Hadoop.

- MapReduce: MapReduce se diseñó originalmente en Google como una forma de procesar páginas web para potenciar la búsqueda de Google. MapReduce distribuye la informática a través de múltiples máquinas en el clúster. MapReduce aprovecha el paralelismo inherente en el procesamiento de datos. Los sistemas modernos, como los sensores o incluso las actualizaciones de estado de Facebook generan millones de registros de datos sin procesar.

Una actividad con este nivel se puede preparar en dos fases:

- Mapa

- Reducir

Usted decide qué lógica desea implementar dentro de estas fases para procesar sus datos.

- HDFS (Sistema de archivos distribuidos de Hadoop): Hadoop está permitiendo una explosión de almacenamiento y análisis de datos a escala en una capacidad ilimitada. Los desarrolladores están utilizando una aplicación como Pig, Hive, HBase y Spark para recuperar datos de HDFS.

Caracteristicas

Apache Pig viene con las siguientes características diferentes:

- La simplicidad de la programación: Pig Latin es comparable a SQL y, por lo tanto, es bastante simple para los desarrolladores crear un script Pig. En caso de que comprenda el lenguaje SQL, es increíblemente simple aprender el lenguaje Pig Latin, ya que es como el lenguaje SQL.

- Conjunto rico de operadores: Pig incluye una variedad de conjunto rico de operadores para poder ejecutar procedimientos como unir, archivar, ordenar y mucho más.

- Posibilidades de optimización: el rendimiento con la tarea en Apache Pig se puede mejorar instantáneamente con la tarea misma; por lo tanto, los desarrolladores solo deben concentrarse en la semántica de este lenguaje.

- Extensibilidad: utilizando operadores accesibles, los usuarios pueden simplemente desarrollar sus funciones para leer, procesar y escribir datos.

- Funciones definidas por el usuario (UDF): al utilizar el servicio proporcionado por Pig para hacer UDF, podríamos producir funciones definidas por el usuario en la cantidad de lenguajes de desarrollo, incluido Java, así como invocar o incrustarlos en Pig Scripts.

¿Para qué es útil el cerdo?

Se utiliza para examinar y ejecutar responsabilidades, incluido el manejo ad-hoc. Apache Pig se puede utilizar para:

El análisis con enormes colecciones de datos sin procesar prefiere el procesamiento de datos para obtener sitios web de búsqueda. Como Yahoo, Google beneficia a Apache Pig para evaluar los datos recopilados a través de Google, así como los motores de búsqueda de Yahoo. Manejo de grandes colecciones de datos como registros web, transmisión de información en línea, etc. Incluso las actualizaciones de estado de Facebook generan millones de registros de datos sin procesar.

¿Cómo te ayuda esta tecnología a crecer en tu carrera?

Muchas organizaciones están implementando Apache Pig increíblemente rápido. Esto significa que las profesiones en las carreras de cerdos y cerdos están aumentando diariamente. Ha habido un gran progreso en el desarrollo de Apache Hadoop en los últimos años. Elementos de Hadoop como Hive, Pig, HDFS, HBase, MapReduce, etc.

Aunque las ofertas de Hadoop llegaron a su segunda década en este momento, sin embargo, ha explotado en reconocimiento en los últimos tres o cuatro años. Una gran cantidad de compañías de software están aplicando clústeres de Hadoop de manera increíblemente común. Esta puede ser definitivamente la mejor parte de Big Data. Los expertos en puntería podrían convertirse en expertos en esta excelente tecnología.

Conclusión

Apache Pig Expertise es un gran requisito en el mercado y puede continuar siendo extendido. Simplemente entendiendo los conceptos y obteniendo experiencia con las mejores habilidades de Apache Pig en Hadoop, los expertos pueden participar perfectamente en su profesión de Apache Pig.

Artículo recomendado

Esta ha sido una guía de ¿Qué es el cerdo? Aquí discutimos los conceptos, la definición y la arquitectura con las características de Pig. También puede consultar nuestros otros artículos sugeridos para obtener más información:

- Cómo instalar Apache

- Preguntas de la entrevista de Apache PIG

- ¿Qué son los servicios web ASP.Net?

- ¿Qué es la tecnología Blockchain?