Introducción a los métodos del núcleo en el aprendizaje automático

El algoritmo utilizado para el Análisis de patrones se denomina Método Kernel en Machine Learning. En general, el análisis se realiza para encontrar relaciones en conjuntos de datos. Estas relaciones pueden ser agrupamiento, clasificación, componentes principales, correlación, etc. La mayoría de estos algoritmos que resuelven estas tareas de análisis del patrón, necesitan los datos en un representante sin procesar, para transformarse explícitamente en una representación vectorial de características. Esta transformación se puede realizar a través de un mapa de características especificado por el usuario. Por lo tanto, se puede considerar que solo el núcleo especificado por el usuario es requerido por el método del núcleo.

La terminología del Método Kernal proviene del hecho de que utilizan la función del núcleo, que les permite realizar la operación en un espacio de características implícitas de alta dimensión sin la necesidad de calcular las coordenadas de los datos en ese espacio. En cambio, simplemente calculan el producto interno entre las imágenes de todos los pares de datos en el espacio de características.

Este tipo de operaciones son computacionalmente más baratas la mayor parte del tiempo en comparación con el cálculo explícito de las coordenadas. Esta técnica se denomina "truco del núcleo". Cualquier modelo lineal puede convertirse en un modelo no lineal aplicando el truco del núcleo al modelo.

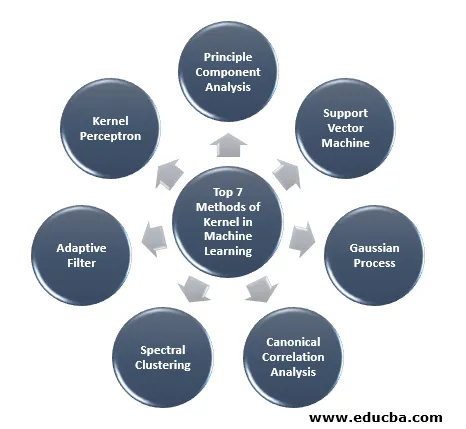

El método de kernel disponible en el aprendizaje automático es el análisis de componentes principales (PCA), el agrupamiento espectral, las máquinas de vectores de soporte (SVM), el análisis de correlación canónica, el perceptrón de kernel, los procesos gaussianos, la regresión de crestas, los filtros lineales adaptativos y muchos otros. Tengamos una comprensión de alto nivel de algunos de estos métodos del núcleo.

Los 7 métodos principales de Kernel en Machine Learning

Estos son los métodos de Kernel en Machine Learning que se mencionan a continuación:

1. Análisis de componentes principales

El análisis de componentes principales (PCA) es una técnica para extraer estructura de conjuntos de datos posiblemente de alta dimensión. Se realiza fácilmente utilizando algoritmos iterativos que estiman componentes principales o resolviendo un problema de valor propio. PCA es una transformación ortogonal del sistema de coordenadas en el que describimos nuestros datos. El nuevo sistema de coordenadas se obtiene por proyección en los ejes principales de los datos. Un pequeño número de componentes principales suele ser suficiente para dar cuenta de la mayor parte de la estructura de los datos. Una de sus principales aplicaciones es realizar análisis exploratorios de datos para hacer un modelo predictivo. Se utiliza principalmente para visualizar la relación entre las poblaciones y la distancia genética.

2. Máquina de vectores de soporte

SVM se puede definir como un clasificador para separar el hiperplano donde el hiperplano es el subespacio de una dimensión menor que el espacio ambiental. La dimensión de este espacio matemático se define como el número mínimo de coordenadas requeridas para especificar cualquier punto, mientras que el espacio ambiental es el espacio que rodea al objeto matemático. Ahora, el objeto matemático puede entenderse como un objeto abstracto que no existe en ningún momento o lugar, sino que existe como un tipo de cosa.

3. Proceso gaussiano

El proceso gaussiano lleva el nombre de Cark Friedrich Gauss porque utiliza la notación de distribución gaussiana (distribución normal). Es un proceso estocástico que significa una colección de variables aleatorias indexadas por tiempo o espacio. En el proceso gaussiano, las variables aleatorias tienen una distribución normal multivariada, es decir, todas las combinaciones lineales finitas de la misma se distribuyen normalmente. El proceso gaussiano utiliza las propiedades heredadas de una distribución normal y, por lo tanto, son útiles en el modelado estadístico. El algoritmo de Machine Learning que involucra este método de kernel utiliza la medida del aprendizaje diferido y la similitud entre puntos para predecir el valor de los puntos invisibles de los datos de entrenamiento. Esta predicción no es solo la estimación sino la incertidumbre en ese punto.

4. Análisis de correlación canónica

El análisis de correlación canónica es una forma de inferir información de matrices de covarianza cruzada. También se conoce como análisis de variaciones canónicas. Supongamos que tenemos dos vectores X, Y de variable aleatoria, digamos dos vectores X = (X1, …, Xn) y el vector Y = (Y1, …, Ym), y la variable tiene correlación, entonces CCA calculará una combinación lineal de X e Y que tiene la correlación máxima entre sí.

5. Agrupación espectral

En la aplicación de la segmentación de imágenes, la agrupación espectral se conoce como categorización de objetos basada en la segmentación. En el agrupamiento espectral, la reducción de la dimensionalidad se realiza antes del agrupamiento en menos dimensiones, esto se hace utilizando el valor propio de la matriz de similitud de los datos. Tiene sus raíces en la teoría de gráficos, donde este enfoque se utiliza para identificar comunidades de nodos en un gráfico que se basa en los bordes que los conectan. Este método es lo suficientemente flexible y también nos permite agrupar datos de no gráficos.

6. Filtro adaptativo

El filtro adaptativo utiliza un filtro lineal que comprende una función de transferencia, que se controla mediante parámetros variables y los métodos, que se utilizarán para ajustar estos parámetros según el algoritmo de optimización. La complejidad de este algoritmo de optimización es la razón por la cual todo filtro adaptativo es un filtro digital. Se necesita un filtro adaptativo en aquellas aplicaciones donde no hay información previa sobre la operación de procesamiento deseada de antemano o están cambiando.

La función de costo se utiliza en el filtro adaptativo de circuito cerrado, ya que es necesario para el rendimiento óptimo del filtro. Determina cómo modificar la función de transferencia de filtro para reducir el costo de la próxima iteración. Una de las funciones más comunes es el error cuadrado medio de la señal de error.

7. Kernel Perceptron

En el aprendizaje automático, el perceptrón del núcleo es un tipo del popular algoritmo de aprendizaje del perceptrón que puede aprender las máquinas del núcleo, como los clasificadores no lineales que utilizan una función del núcleo para calcular la similitud de esas muestras que no se ven a las muestras de entrenamiento. Este algoritmo fue inventado en 1964, convirtiéndolo en el primer alumno de clasificación de kernel.

La mayoría de los algoritmos de kernel discutidos se basan en optimización convexa o problemas propios y son estadísticamente bien fundados. Sus propiedades estadísticas se analizan utilizando la teoría del aprendizaje estadístico.

Hablando de las áreas de aplicación de los métodos de kernel, es diverso e incluye geoestadística, kriging, ponderación de distancia inversa, reconstrucción 3D, bioinformática, quimioinformática, extracción de información y reconocimiento de escritura a mano.

Conclusión

He resumido algunas de las terminologías y tipos de métodos de kernel en Machine Learning. Debido a la falta de espacio, este artículo de ninguna manera es exhaustivo y solo tiene la intención de darle una comprensión de lo que es el método del núcleo y un breve resumen de sus tipos. Sin embargo, cubrir este artículo te hará dar el primer paso en el campo del aprendizaje automático.

Artículos recomendados

Esta es una guía del Método Kernel en Machine Learning. Aquí discutimos los 7 tipos de métodos de kernel en Machine Learning. También puede consultar el siguiente artículo.

- Kernel monolítico

- Agrupación en Machine Learning

- Aprendizaje automático de ciencia de datos

- Aprendizaje automático sin supervisión

- Filtros PHP | ¿Cómo validar la entrada del usuario usando varios filtros?

- Guía completa del ciclo de vida del aprendizaje automático