Introducción a la arquitectura de Big Data

Cuando se trata de administrar datos pesados y realizar operaciones complejas en esos datos masivos, es necesario utilizar herramientas y técnicas de big data. Cuando decimos que el uso de herramientas y técnicas de big data, queremos decir que estamos pidiendo hacer uso de diversos programas y procedimientos que se encuentran en el ecosistema de big data y su esfera. No se proporciona una solución genérica para cada caso de uso y, por lo tanto, debe diseñarse y fabricarse de manera efectiva según los requisitos comerciales de una empresa en particular. Por lo tanto, es necesario utilizar diferentes arquitecturas de big data, ya que la combinación de varias tecnologías dará como resultado el caso de uso resultante. Al establecer una arquitectura fija, se puede garantizar que se proporcionará una solución viable para el caso de uso solicitado.

¿Qué es la arquitectura de Big Data?

- Esta arquitectura está diseñada de tal manera que maneja el proceso de ingestión, el procesamiento de datos y el análisis de los datos que es demasiado grande o complejo para manejar los sistemas tradicionales de administración de bases de datos.

- Las diferentes organizaciones tienen umbrales diferentes para sus organizaciones, algunas lo tienen por unos pocos cientos de gigabytes, mientras que para otras, incluso algunos terabytes no son un valor umbral suficientemente bueno.

- Debido a este evento que ocurre si observa los sistemas de productos básicos y el almacenamiento de productos básicos, los valores y el costo de almacenamiento se han reducido significativamente. Existe una gran variedad de datos que exige diferentes formas de ser atendidos.

- Algunos de ellos son datos relacionados con lotes que llegan en un momento determinado y, por lo tanto, los trabajos deben programarse de manera similar, mientras que otros pertenecen a la clase de transmisión en la que se debe construir una tubería de transmisión en tiempo real para atender a todos los requisitos Todos estos desafíos se resuelven mediante la arquitectura de big data.

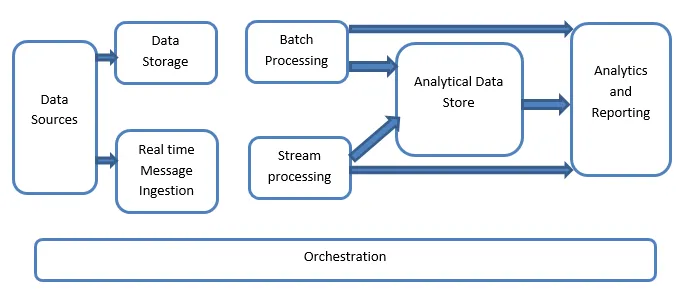

Explicación de la arquitectura de Big Data:

Los sistemas de Big Data involucran más de un tipo de carga de trabajo y se clasifican en términos generales de la siguiente manera:

- Cuando las grandes fuentes basadas en datos están en reposo, el procesamiento por lotes está involucrado.

- Gran procesamiento de datos en movimiento para procesamiento en tiempo real.

- Exploración de herramientas y tecnologías interactivas de big data.

- Aprendizaje automático y análisis predictivo.

1. Fuentes de datos

Las fuentes de datos involucran a todas esas fuentes de oro desde donde se construye la tubería de extracción de datos y, por lo tanto, se puede decir que este es el punto de partida de la tubería de datos grandes.

Los ejemplos incluyen:

(i) Almacenes de datos de aplicaciones como las bases de datos relacionales

(ii) Los archivos que son producidos por una serie de aplicaciones y son principalmente una parte de los sistemas de archivos estáticos, como los archivos de servidor basados en web que generan registros.

(iii) dispositivos IoT y otras fuentes de datos basadas en tiempo real.

2. Almacenamiento de datos

Esto incluye los datos que se administran para las operaciones compiladas por lotes y se almacenan en los almacenes de archivos que se distribuyen en la naturaleza y también son capaces de almacenar grandes volúmenes de archivos grandes con respaldo de diferentes formatos. Se llama el lago de datos. Esto generalmente forma parte de nuestro almacenamiento Hadoop, como HDFS, Microsoft Azure, AWS, almacenamiento GCP, junto con contenedores de blobs.

3. Procesamiento por lotes

Todos los datos se segregan en diferentes categorías o fragmentos, lo que hace uso de trabajos de larga duración utilizados para filtrar y agregar y también preparar datos o estados procesados para su análisis. Estos trabajos generalmente utilizan fuentes, los procesan y proporcionan la salida de los archivos procesados a los nuevos archivos. El procesamiento por lotes se realiza de varias maneras haciendo uso de trabajos de Hive o trabajos basados en U-SQL o haciendo uso de Sqoop o Pig junto con los trabajos de reducción de mapas personalizados que generalmente se escriben en cualquiera de Java o Scala o en cualquier otro lenguaje como Python.

4. Ingestión de mensajes basada en tiempo real

Esto incluye, en contraste con el procesamiento por lotes, todos esos sistemas de transmisión en tiempo real que atienden a los datos que se generan secuencialmente y en un patrón fijo. A menudo, se trata de una tienda o almacén de datos simple responsable de todos los mensajes entrantes que se dejan caer dentro de la carpeta que se usa necesariamente para el procesamiento de datos. Sin embargo, la mayoría de las soluciones que requieren la necesidad de un almacén de ingestión basado en mensajes que actúe como un búfer de mensajes y que también sea compatible con el procesamiento basado en escala, proporciona una entrega relativamente confiable junto con otras semánticas de colas de mensajes. Las opciones incluyen aquellas como Apache Kafka, Apache Flume, Centros de eventos de Azure, etc.

5. Procesamiento de flujo

Hay una ligera diferencia entre la ingestión de mensajes en tiempo real y el procesamiento de la transmisión. El primero tiene en cuenta los datos ingeridos que se recopilan al principio y luego se utilizan como una herramienta de publicación, suscripción y suscripción. El procesamiento de flujo, por otro lado, se usa para manejar todos los datos de flujo que ocurren en ventanas o flujos y luego escribe los datos en el sumidero de salida. Esto incluye Apache Spark, Apache Flink, Storm, etc.

6. Almacén de datos basado en análisis

Este es el almacén de datos que se utiliza con fines analíticos y, por lo tanto, los datos ya procesados se consultan y analizan utilizando herramientas de análisis que pueden corresponder a las soluciones de BI. Los datos también se pueden presentar con la ayuda de una tecnología de almacenamiento de datos NoSQL como HBase o cualquier uso interactivo de la base de datos de la colmena que puede proporcionar la abstracción de metadatos en el almacén de datos. Las herramientas incluyen Hive, Spark SQL, Hbase, etc.

7. Informes y análisis

Los conocimientos deben generarse sobre los datos procesados y eso se hace de manera efectiva mediante las herramientas de informes y análisis que hacen uso de su tecnología y solución integradas para generar gráficos, análisis y conocimientos útiles para las empresas. Las herramientas incluyen Cognos, Hyperion, etc.

8. Orquestación

Las soluciones basadas en grandes datos consisten en operaciones relacionadas con datos que son de naturaleza repetitiva y también están encapsuladas en los flujos de trabajo que pueden transformar los datos de origen y también mover datos a través de fuentes, así como sumideros y cargarlos en almacenes y empujarlos a unidades analíticas. Los ejemplos incluyen Sqoop, oozie, fábrica de datos, etc.

Conclusión

En esta publicación, leemos sobre la arquitectura de big data que es necesaria para que estas tecnologías se implementen en la empresa o la organización. Espero que les haya gustado nuestro artículo.

Artículos recomendados

Esta ha sido una guía para la arquitectura de Big Data. Aquí discutimos qué es big data? y también hemos explicado la arquitectura de big data junto con el diagrama de bloques. También puede consultar nuestros otros artículos sugeridos para obtener más información:

- Tecnologías de Big Data

- Análisis de Big Data

- Carreras en Big Data

- Preguntas de la entrevista de Big Data

- Los 8 mejores dispositivos de IoT que debes saber

- Tipos de combinaciones en Spark SQL (ejemplos)