Introducción al aprendizaje automático de ciencia de datos

Los datos son básicamente información, especialmente hechos o números, recopilados para ser examinados y considerados y utilizados para ayudar a la toma de decisiones o información en forma electrónica que puede ser almacenada y utilizada por una computadora. Ahora, aprenderemos la definición de ciencia de datos y aprendizaje automático.

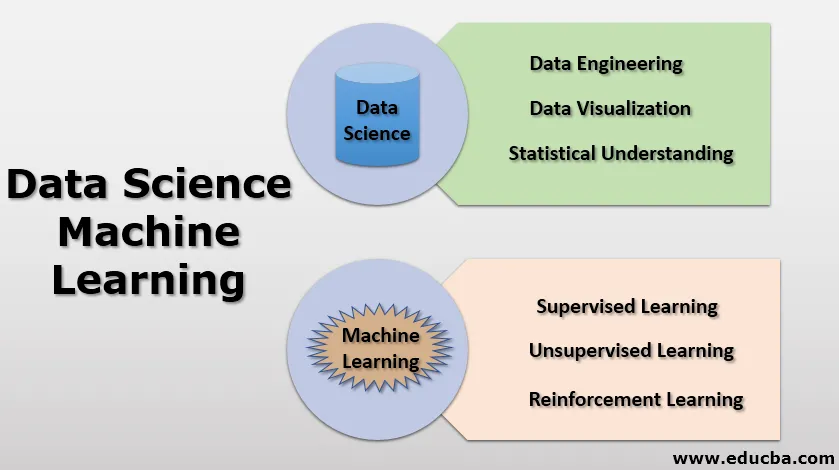

Data Science (DS) : es un campo muy amplio donde se utilizan diferentes técnicas como métodos estadísticos, enfoques científicos, procesos arquitectónicos, diversos algoritmos para extraer información perspicaz de los datos disponibles que podrían ser datos estructurados o no estructurados.

Machine Learning ( ML ): es un subconjunto de Data Science. En el aprendizaje automático, básicamente con la ayuda de modelos estadísticos y algoritmos diferentes, las máquinas se entrenan sin dar instrucciones explícitas, se basa en patrones creados con datos ".

Importancia de la ciencia de datos

- Estamos viviendo en una era de tecnología, donde cada persona de una manera u otra utiliza la tecnología para mayor comodidad / efectividad / facilidad, por ejemplo, teléfonos celulares / computadoras portátiles / tabletas para la comunicación, automóviles / trenes / autobuses / aviones para el transporte, servicios como banca / electricidad y muchos más para facilitar la vida.

- En cada una de estas ocasiones, estamos creando datos a sabiendas o sin saberlo, como registros de llamadas / mensajes de texto / redes sociales: las imágenes / videos / blogs son parte de los datos, con el transporte nuestra navegación a diferentes lugares por GPS / el rendimiento del vehículo grabado a través de ECU también es parte de los datos. Nuestras transacciones en billeteras bancarias y móviles crean una gran cantidad de datos, el consumo de electricidad por cualquier área o sector también es parte de los datos.

- Y decir que estos datos aumentan exponencialmente día a día o minuto a minuto.

- Ahora surge la pregunta: ¿podemos hacer algo con estos datos? ¿Podemos usar estos datos para proporcionar algunas ideas útiles? ¿Podemos aumentar la efectividad? ¿Podemos usar estos datos para predecir resultados futuros?

- Para responder a todas esas preguntas, tenemos un campo llamado ciencia de datos.

- Data Science se puede considerar como un campo amplio que comprende minería de datos, ingeniería de datos, visualización de datos, métodos estadísticos de integración de datos, programación R / python / SQL, aprendizaje automático, Big data y más.

Ahora comprendamos los conceptos importantes de la ciencia de datos.

1. Ingeniería de datos

La ingeniería de datos es uno de los aspectos de la ciencia de datos que se enfoca principalmente en aplicaciones de datos, recolección de datos y análisis de datos. Todo el trabajo que realizan los científicos de datos, como responder a varias preguntas relacionadas con predicciones o análisis, utiliza una gran cantidad de información.

Ahora lo que necesitan es información correcta y útil, lo que crea la necesidad de recopilar y validar la información disponible. Todos estos son parte de las tareas de ingeniería. Algunas de estas tareas son verificar valores nulos (datos faltantes), clasificar los datos (datos categóricos), crear estructuras de datos (reglas de asociación), etc.

2. Visualización de datos

La visualización de datos es un enfoque gráfico para representar los datos. Aquí usamos la biblioteca incorporada de Python para crear elementos visuales, por ejemplo, tablas, gráficos de correlación, gráficos de barras, gráficos de pares, etc. La visualización de datos juega un papel muy importante para proporcionar una manera muy fácil de analizar los datos, ver y comprender tendencias, figura fuera de los valores atípicos, etc.

3. Comprensión estadística

Las estadísticas juegan un papel muy importante en el campo de la ciencia de datos. La estadística es una herramienta muy poderosa para realizar las tareas de Data Science (DS). Las estadísticas usan las matemáticas para hacer análisis técnicos de la información disponible. Con visualizaciones como una barra o un gráfico, podemos obtener la información de tendencia, pero las estadísticas nos ayudan a operar sobre los datos de manera matemática / específica. Sin el conocimiento de los datos, la visualización científica es solo un juego de adivinanzas.

Analizaremos algunos métodos estadísticos importantes que los científicos de datos utilizan a diario.

- Media: La media es básicamente un promedio de todos los datos, calculado sumando todos los elementos de datos y luego dividiéndolos por una cantidad de elementos. Se utiliza para identificar el valor central de todos los elementos.

- Mediana: la mediana también se usa para encontrar el valor central de los elementos disponibles, pero aquí todos los datos se organizan en un orden y el valor medio exacto se considera como una mediana.

Si el número de elementos es impar, entonces la mediana es ((n + 1) / 2) término. Si varios elementos son pares, entonces la mediana será ((n / 2) + 1) término.

- Modo: el modo es un parámetro estadístico que señala el más frecuente o el valor que aparece la mayor cantidad de veces se trata como el modo.

- Desviación estándar: la desviación estándar indica la cantidad de propagación presente en los datos o es una medida para definir la propagación a partir de los valores medios o el valor promedio o el valor esperado.

En caso de que tengamos una desviación estándar baja, indica que la mayoría de los valores de datos están cerca del valor promedio. Si tenemos una desviación estándar alta significa que nuestros valores de datos están más separados del valor medio.

- Varianza: la varianza es igual a la desviación estándar con una pequeña diferencia, es un cuadrado de desviación estándar. La desviación estándar se deriva de la varianza porque la desviación estándar muestra la propagación en términos de datos, mientras que la varianza muestra la propagación con un cuadrado. Es fácil correlacionar la propagación utilizando la varianza.

- Correlación: la correlación es una de las medidas estadísticas más importantes, indica cómo se relacionan las variables en el conjunto de datos. Cuando cambiamos un parámetro, cómo afecta al otro parámetro.

Si tenemos un valor de correlación positivo, lo que significa que las variables aumentarán o disminuirán en paralelo

Si tenemos un valor de correlación negativo, lo que significa que las variables se comportarán inversamente en un incremento de las otras disminuirán y viceversa.

En estadística, tenemos una distribución de probabilidad, estadísticas bayesianas y pruebas de hipótesis que también son herramientas muy importantes para un científico de datos.

Aprendizaje automático

Aprendizaje automático básicamente significa una forma en que las máquinas pueden aprender y producir resultados basados en características de entrada.

Definición: "El aprendizaje automático es un campo de estudio donde la computadora aprende de los datos disponibles / datos históricos sin ser programado explícitamente"

En el aprendizaje automático, la atención se centra en automatizar y mejorar el proceso de aprendizaje de las computadoras en función de sus experiencias de datos de entrada, y no programaremos el código explícitamente para cada tipo de problema, es decir, la máquina descubrirá cómo abordar el problema. Aquí los resultados pueden no ser precisos, pero se puede hacer una buena predicción.

Vamos a entenderlo de esta manera:

Tradicionalmente, las computadoras se utilizan para facilitar el proceso de cálculo. entonces si tenemos algún cálculo aritmético. ¿Que haremos? Prepararemos un programa de computadora que resolverá esa operación de manera fácil y rápida. por ejemplo, si queremos agregar dos entidades, crearemos una pieza de código de software que tomará dos entradas y en la salida, mostrará la suma.

En el enfoque de aprendizaje automático es diferente, en lugar de alimentar un algoritmo directo, se coloca un algoritmo especial en el código del software que intentará reconocer un patrón y, basándose en esos patrones, tratará de predecir el mejor resultado posible. Aquí no estamos codificando ningún algoritmo explícitamente para ninguna operación específica, en cambio, estamos enviando datos a una máquina para aprender cuál es el patrón y cuál podría ser la salida.

Ahora, ¿por qué debemos adoptar este enfoque cuando podemos obtener directamente los resultados exactos simplemente codificando el algoritmo exacto? Los algoritmos exactos son complejos y limitados. Veámoslo desde una perspectiva diferente, esta es una era en la que tenemos una gran cantidad de datos y está explotando todos los días como hemos discutido en la sección anterior. Aquí nos ocupamos del aprendizaje supervisado y no supervisado.

El aprendizaje automático es de gran interés hoy en día porque tenemos una gran cantidad de datos. Para dar sentido a estos datos, necesitamos tener algunos resultados significativos o algunos patrones significativos, que puedan analizarse y ponerse en práctica.

Pero aún así, ¿por qué nos interesa el aprendizaje automático y estos datos?

Sabemos que la humanidad simplemente reproduce la historia como si fuéramos lo mismo que nuestras generaciones anteriores, y nuestros descendientes también enfrentarán varias situaciones similares a las que nos enfrentamos o nos enfrentamos ahora. En esta etapa, debemos imaginar cómo reaccionar para el futuro utilizando datos históricos.

Así que ahora sabemos que los datos son un activo muy valioso.

El desafío es ¿Cómo podemos utilizar mejor estos datos disponibles?

Este es el tema más interesante (¿Cómo?), Donde vamos a dar sentido a los datos disponibles. Existen básicamente 3 enfoques para el aprendizaje automático:

- Aprendizaje supervisado

- Aprendizaje sin supervisión

- Aprendizaje reforzado

Estos tres enfoques se utilizan para crear un modelo de aprendizaje automático como (regresión lineal, regresión logística, bosque aleatorio, árboles de decisión, etc.).

Existe una amplia variedad de aplicaciones de estos modelos de aprendizaje automático, por ejemplo:

- Finanzas: detección de fraude

- Marketing / Ventas: personalice la recomendación

- Cuidado de la salud: identificar la tendencia de la enfermedad.

Conclusión - Aprendizaje automático de ciencia de datos

- Data Science es un campo amplio del cual el aprendizaje automático es un subconjunto. En esto, analizamos los datos históricos disponibles con nosotros e intentamos predecir los resultados futuros más probables.

- Para predecir que necesitamos limpiar los datos, organizar los datos (ingeniería de datos). Con los datos en la mano, visualizamos el patrón / tendencias y luego, con la comprensión estadística, inferimos información perspicaz.

- Estos datos se enviarán a una máquina utilizando un algoritmo de aprendizaje automático.

- Estos algoritmos entrenan la máquina y crean un modelo de aprendizaje automático.

- Este modelo se puede usar para la predicción.

Artículos recomendados

Esta es una guía de Data Science Machine Learning. Aquí discutimos la importancia de la ciencia de datos junto con el aprendizaje automático. También puede consultar los siguientes artículos para obtener más información:

- Los mejores programas de ciencia de datos

- Habilidades de ciencia de datos

- Lenguajes de ciencia de datos

- Técnicas de aprendizaje automático

- ¿Qué es la integración de datos?

- Cómo se usa el gráfico de barras en Matlab (ejemplos)

- Árbol de decisión en el aprendizaje automático

- Formas simples de crear árbol de decisión