Diferencia entre Apache Storm y Apache Spark

Apache Storm es un sistema de cómputo en tiempo real de código abierto, escalable, tolerante a fallas y distribuido. Apache Storm se centra en el procesamiento de secuencias o el procesamiento de eventos. Apache Storm implementa un método tolerante a fallas para realizar un cálculo o canalizar múltiples cálculos en un evento a medida que fluye hacia un sistema. Apache Spark es un marco de tecnología de computación en clúster y ultrarrápido, diseñado para la computación rápida en el procesamiento de datos a gran escala. Apache Spark es un motor de procesamiento distribuido, pero no viene con un administrador de recursos de clúster incorporado y un sistema de almacenamiento distribuido. Debe conectar el administrador de clúster y el sistema de almacenamiento que elija.

Presentamos más sobre Apache Storm vs Apache Spark:

- Apache Storm es un motor computacional continuo de tareas paralelas. Define sus flujos de trabajo en Gráficos Acíclicos Dirigidos (DAG) llamados topologías. Estas topologías se ejecutan hasta que el usuario las apaga o encuentra un error irrecuperable. Apache Storm no se ejecuta en clústeres de Hadoop, pero utiliza Zookeeper y su propio trabajador minion para administrar sus procesos. Apache Storm puede leer y escribir archivos en HDFS.

- Apache Storm se integra con las tecnologías de colas y bases de datos que ya usa. Una topología de Storm consume flujos de datos y procesa esos flujos de manera arbitrariamente compleja, reparticionando los flujos entre cada etapa de la computación según sea necesario. Apache Storm se basa en tuplas y corrientes. Una tupla es básicamente cuáles son sus datos y cómo están estructurados.

- El marco Apache Spark consta de Spark Core y un conjunto de bibliotecas. Spark core ejecuta y gestiona nuestro trabajo al proporcionar una experiencia perfecta al usuario final. Un usuario debe enviar un trabajo a Spark core y Spark core se encarga de procesar, ejecutar y responder al usuario. Tenemos Spark Core API en diferentes lenguajes de script como Scala, Python, Java y R.

- En Apache Spark, el usuario puede usar Apache Storm para transformar datos no estructurados a medida que fluyen en el formato deseado. Debe conectar el administrador de clúster y el sistema de almacenamiento que elija.

- Puede elegir Apache YARN o Mesos para el administrador de clúster para Apache Spark.

- Puede elegir Hadoop Distributed File System (HDFS), almacenamiento en la nube de Google, Amazon S3, Microsoft Azure para el administrador de recursos de Apache Spark.

- Apache Spark es un motor de procesamiento de datos para modos por lotes y de transmisión que ofrece consultas SQL, procesamiento de gráficos y aprendizaje automático.

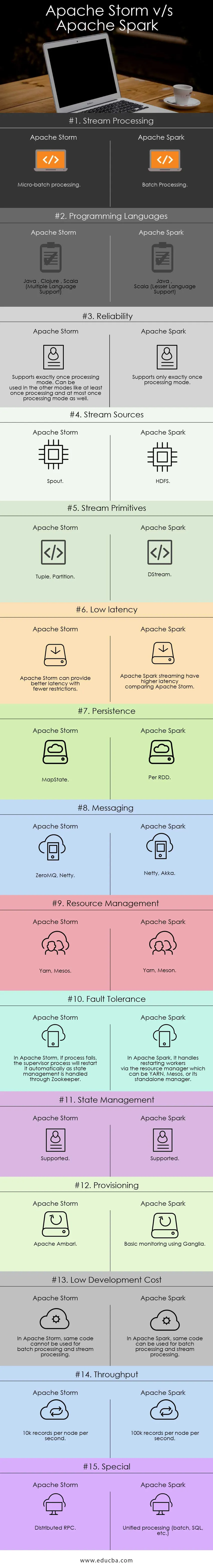

Comparación cabeza a cabeza entre Apache Storm y Apache Spark (infografía):

Diferencias clave entre Apache Storm y Apache Spark:

A continuación se encuentran las listas de puntos, describa las diferencias clave entre Apache Storm y Apache Spark:

- Apache Storm realiza cálculos de tareas paralelas, mientras que Apache Spark realiza cálculos de datos paralelos.

- Si el nodo trabajador falla en Apache Storm, Nimbus asigna la tarea de los trabajadores al otro nodo y todas las tuplas enviadas al nodo fallido se agotarán y, por lo tanto, se reproducirán automáticamente mientras que en Apache Spark, si el nodo trabajador falla, el sistema puede volver a calcular desde la copia restante de los datos de entrada y los datos pueden perderse si los datos no se replican.

- La garantía de entrega de Apache Strom depende de una fuente de datos segura, mientras que la fuente de datos respaldada por Apache Spark HDFS es segura.

- Apache Storm es un motor de procesamiento de flujo para procesar datos de flujo en tiempo real, mientras que Apache Spark es un motor informático de propósito general.

Características de la tormenta Apache:

- Tolerancia a fallas: donde si los subprocesos de trabajo mueren o un nodo se cae, los trabajadores se reinician automáticamente

- Escalabilidad: Storm, altamente escalable, puede mantener el rendimiento incluso bajo una carga creciente al agregar recursos linealmente donde se pueden lograr tasas de rendimiento de incluso un millón de mensajes de 100 bytes por segundo por nodo

- Latencia: Storm realiza una actualización de datos y la respuesta de entrega de extremo a extremo en segundos o minutos depende del problema. Tiene muy baja latencia.

- Facilidad de uso en la implementación y operación del sistema.

- Integrado con Hadoop para aprovechar mayores rendimientos

- Fácil de implementar y se puede integrar con cualquier lenguaje de programación.

- Apache Storm es de código abierto, robusto y fácil de usar. Podría ser utilizado en pequeñas empresas, así como en grandes corporaciones.

- Permite el procesamiento de flujo en tiempo real a una velocidad increíblemente rápida y tiene un enorme poder de procesamiento de datos.

- Apache Storm tiene inteligencia operativa.

- Apache Storm proporciona procesamiento de datos garantizado incluso si alguno de los nodos conectados en el clúster muere o se pierden mensajes

Características de Apache Spark:

- Velocidad: Apache Spark ayuda a ejecutar una aplicación en el clúster de Hadoop, hasta 100 veces más rápido en la memoria y 10 veces más rápido cuando se ejecuta en el disco.

- Procesamiento en tiempo real: Apache spark puede manejar datos de transmisión en tiempo real.

- Facilidad de uso : Apache Spark tiene la capacidad de soportar múltiples idiomas como Java, Scala, Python y R

- Evaluación perezosa: en Apache Spark, las transformaciones son de naturaleza perezosa. Dará resultado después de formar un nuevo RDD a partir del existente.

- Integración con Hadoop: Apache Spark puede ejecutarse de forma independiente y también en Hadoop YARN Cluster Manager y, por lo tanto, puede leer los datos existentes de Hadoop.

- Tolerancia a fallos: Apache Spark proporciona tolerancia a fallos utilizando el concepto RDD. Los RDD de Spark están diseñados para manejar la falla de cualquier nodo de trabajo en el clúster.

Tabla comparativa de Apache Storm vs Apache Spark

Estoy discutiendo los principales artefactos y distinguiendo entre Apache Storm y Apache Spark.

| Tormenta de Apache | Apache Spark | |

| Procesamiento de flujo | Procesamiento de micro lotes | Procesamiento por lotes |

| Lenguajes de programación | Java, Clojure, Scala (soporte de múltiples idiomas) | Java, Scala (soporte de idiomas menores) |

| Fiabilidad | Admite exactamente una vez el modo de procesamiento. Se puede usar en los otros modos, como al menos una vez el procesamiento y, como máximo, también en el modo de procesamiento | Admite solo una vez el modo de procesamiento |

| Fuentes de corriente | Canalón | HDFS |

| Primitivas de flujo | Tupla, Partición | DStream |

| Baja latencia | Apache Storm puede proporcionar una mejor latencia con menos restricciones | La transmisión de Apache Spark tiene una latencia más alta en comparación con Apache Storm |

| Persistencia | MapState | Por RDD |

| Mensajería | ZeroMQ, Netty | Netty, Akka |

| Administracion de recursos | Hilo, Mesos | Hilo, Meson |

| Tolerancia a fallos | En Apache Storm, si el proceso falla, el proceso del supervisor lo reiniciará automáticamente a medida que la gestión del estado se maneja a través de Zookeeper | En Apache Spark, maneja el reinicio de los trabajadores a través del administrador de recursos que puede ser YARN, Mesos o su administrador independiente |

| Administración del Estado | Soportado | Soportado |

| Aprovisionamiento | Apache Ambari | Monitoreo básico usando Ganglia |

| Bajo costo de desarrollo | En Apache Storm, no se puede usar el mismo código para el procesamiento por lotes y el procesamiento de flujo | En Apache Spark, se puede usar el mismo código para el procesamiento por lotes y el procesamiento de flujo |

| Rendimiento | 10k registros por nodo por segundo | 100k registros por nodo por segundo |

| Especial | RPC distribuido | Procesamiento unificado (lote, SQL, etc.) |

Conclusión - Apache Storm vs Apache Spark:

Apache Storm y Apache Spark son excelentes soluciones que resuelven el problema de ingestión y transformación de transmisión. Apache Storm y Apache Spark pueden formar parte del clúster Hadoop para procesar datos. Apache Storm es una solución para el procesamiento de flujo en tiempo real. Pero Storm es muy complejo para que los desarrolladores desarrollen aplicaciones debido a los recursos limitados.

Apache Storm se puede utilizar principalmente para el procesamiento de Stream. Pero la industria necesita una solución generalizada que pueda resolver todos los tipos de problemas. Por ejemplo, procesamiento por lotes, procesamiento por secuencias, procesamiento interactivo y procesamiento iterativo. Entonces, Apache Spark entra en el centro de atención, que es un motor de cómputo de propósito general. Esta es la razón por la cual la demanda de Apache Spark es más comparativa de otras herramientas por parte de los profesionales de TI. Apache Spark puede manejar diferentes tipos de problemas. Aparte de esto, Apache Spark es demasiado fácil para los desarrolladores y puede integrarse muy bien con Hadoop. Apache Spark le brinda la flexibilidad de trabajar en diferentes idiomas y entornos.

Artículo recomendado

Esta ha sido una guía de Apache Storm vs Apache Spark, su significado, comparación de cabeza a cabeza, diferencias clave, tabla de comparación y conclusión. También puede consultar los siguientes artículos para obtener más información:

- Iaas vs Azure Pass: diferencias que debe conocer

- Apache Hadoop vs Apache Spark | ¡Las 10 mejores comparaciones que debes conocer!

- 7 Guía increíble sobre Acerca de Apache Spark (Guía)

- Las 15 mejores cosas que debes saber sobre MapReduce vs Spark

- Hadoop vs Apache Spark: cosas interesantes que debes saber